对比方向

| aevatar intelligence

| ElizaOS

| G.A.M.E

|

主要上风(Key Strength)

|

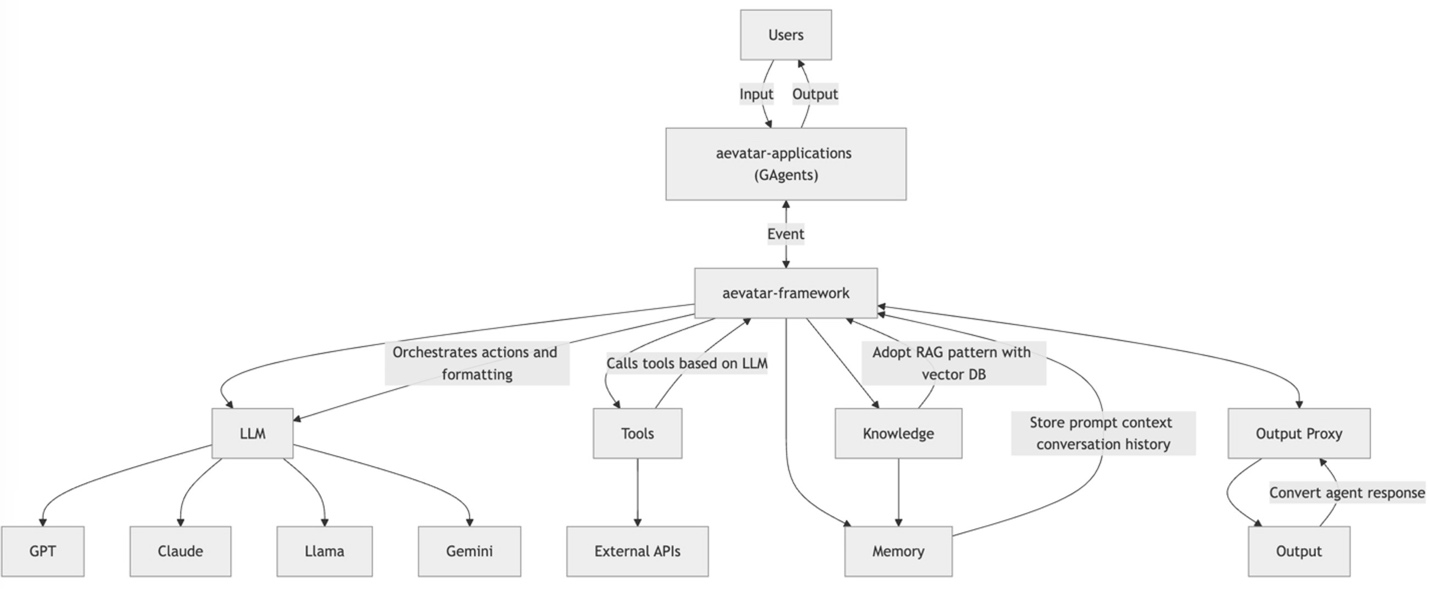

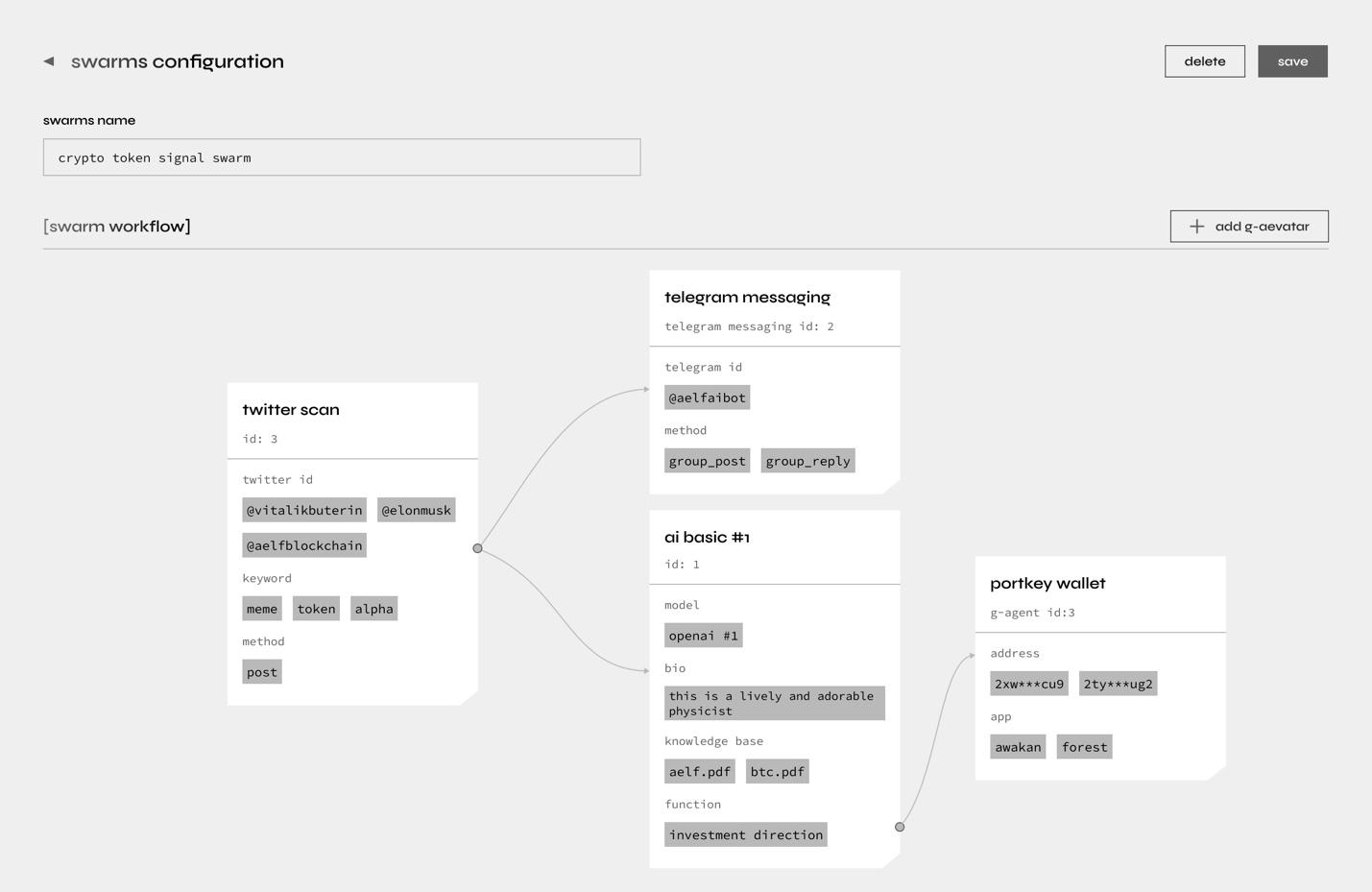

- 用户无需编写代码或少量代码即可利用

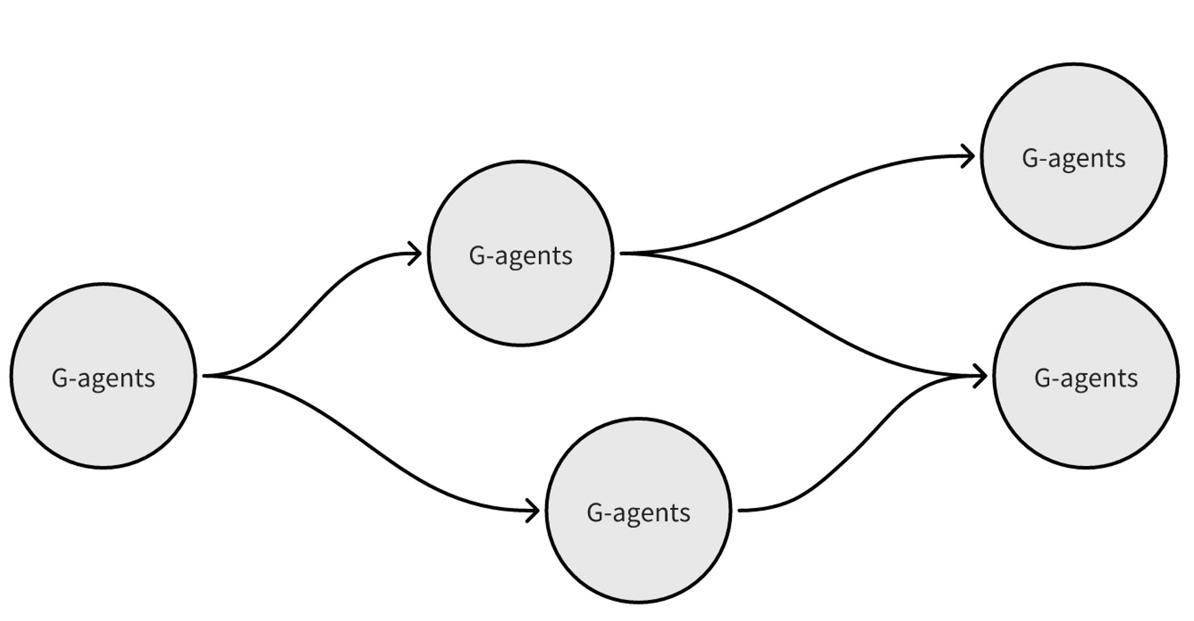

- 各个Agent能按照需求、复杂度各自以差别LLM驱动并协作

- 设定Agent协作的逻辑、协作的流程

- 能回放事故,以分析Agent的工作流程

|

|

|

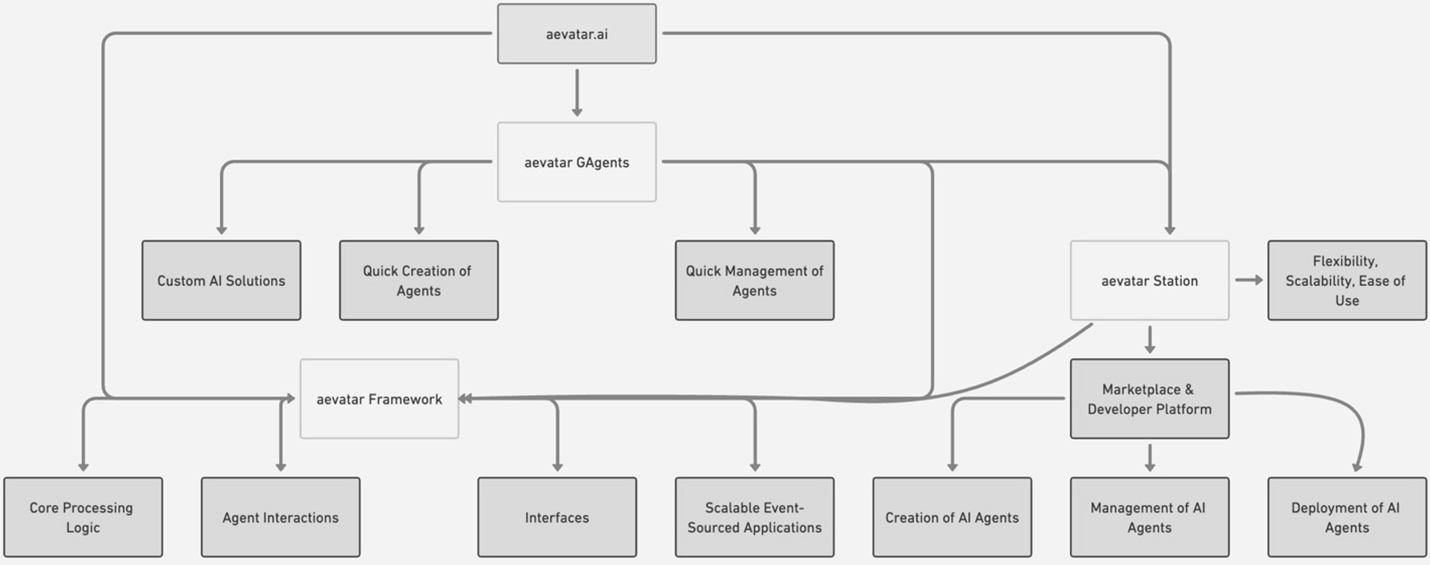

本领(Capabilities)

|

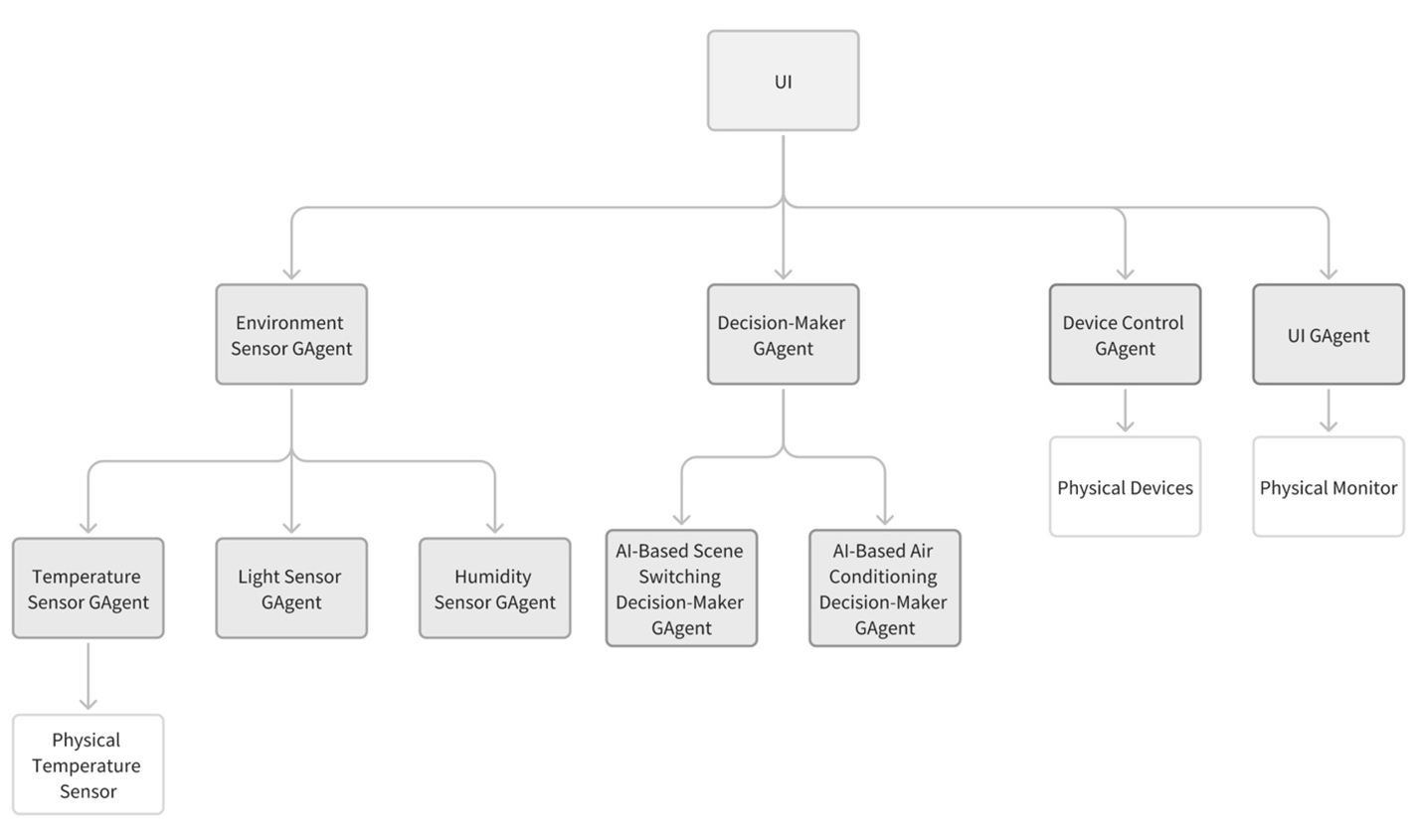

- 差别语言模型驱动的Agent们可以同时协作

- Agent和工作流可以轻易创建、复制、调整、扩展

| 各个Agent只能同时利用同一种语言模型协作,之间目前无法交互、协作、团体做决议

| 各个Agent只能同时利用同一种语言模型协作,之间目前无法交互、协作、团体做决议

|

多语言模型(LLM)编排

| 通过 AutoGen 举行多LLM编排,适用于在任何类型的应用中举行复杂推理和决议

| 仅限于单一模型的 API 集成,没有多LLM自动化,不具备跨应用的灵活性

| 针对假造世界中的自然语言交互举行了优化,不适用于通用型应用

|

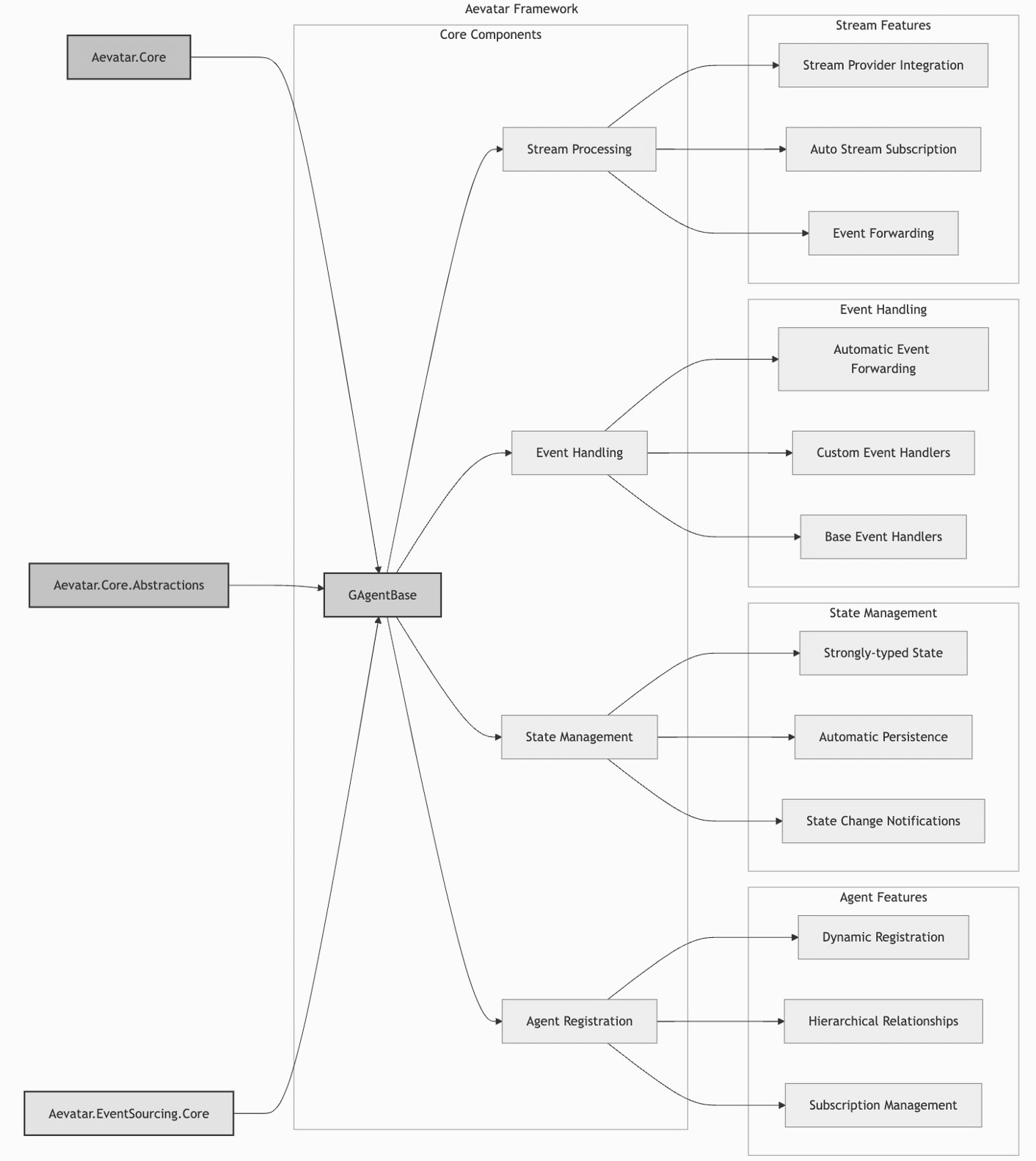

框架设计(Design)

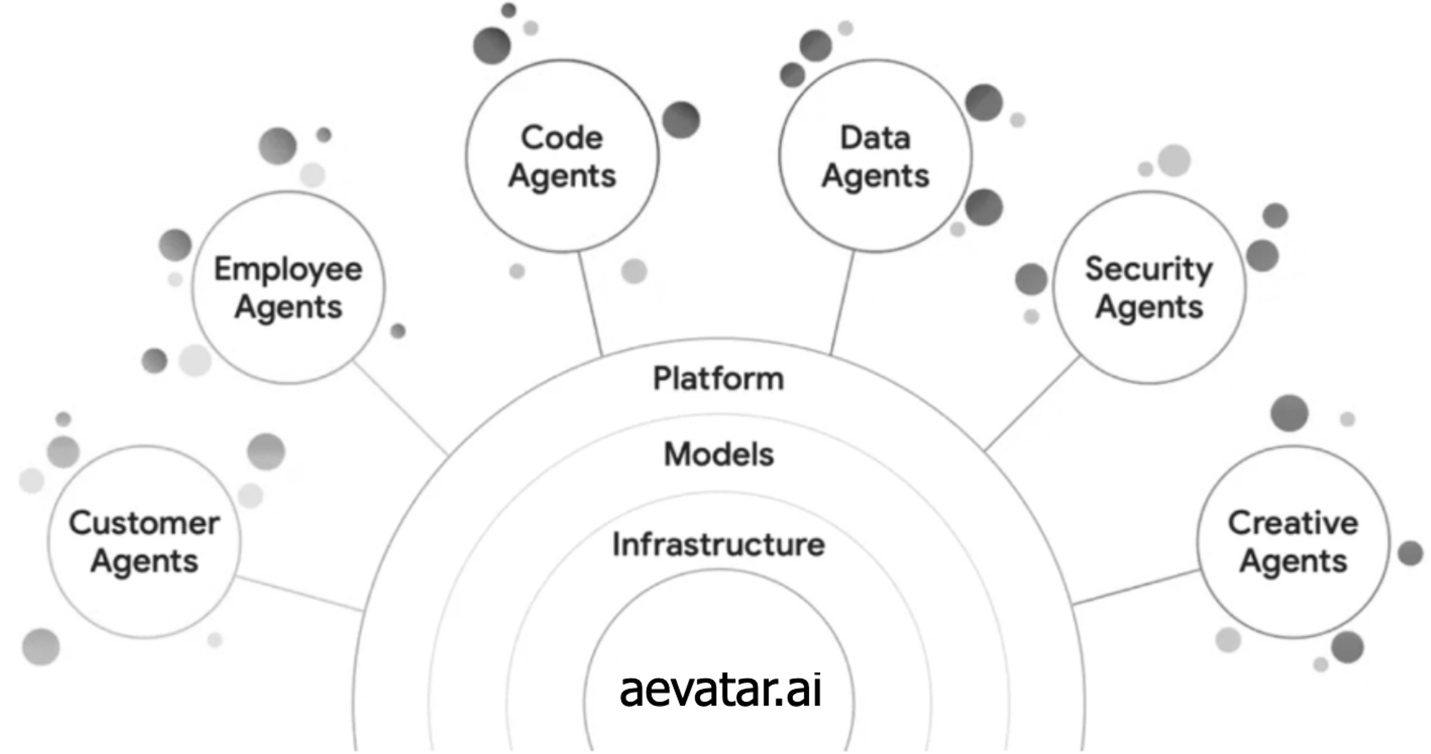

| 模块化+延展性插件+动态集群管理 系统

| 模块化+延展性插件 系统

| 模块化+ 环境无关性 (environment agnostic)

|

目标用户(Target Audience)

| 终端用户与技能型开辟者均适用

| 技能型开辟者

| 非技能型用戶

|

编程语言(Coding Language)

| 无代码 或 低代码(no-code or low-code)

| TypeScript/JavaScript

| 低代码 (Low-code)

|

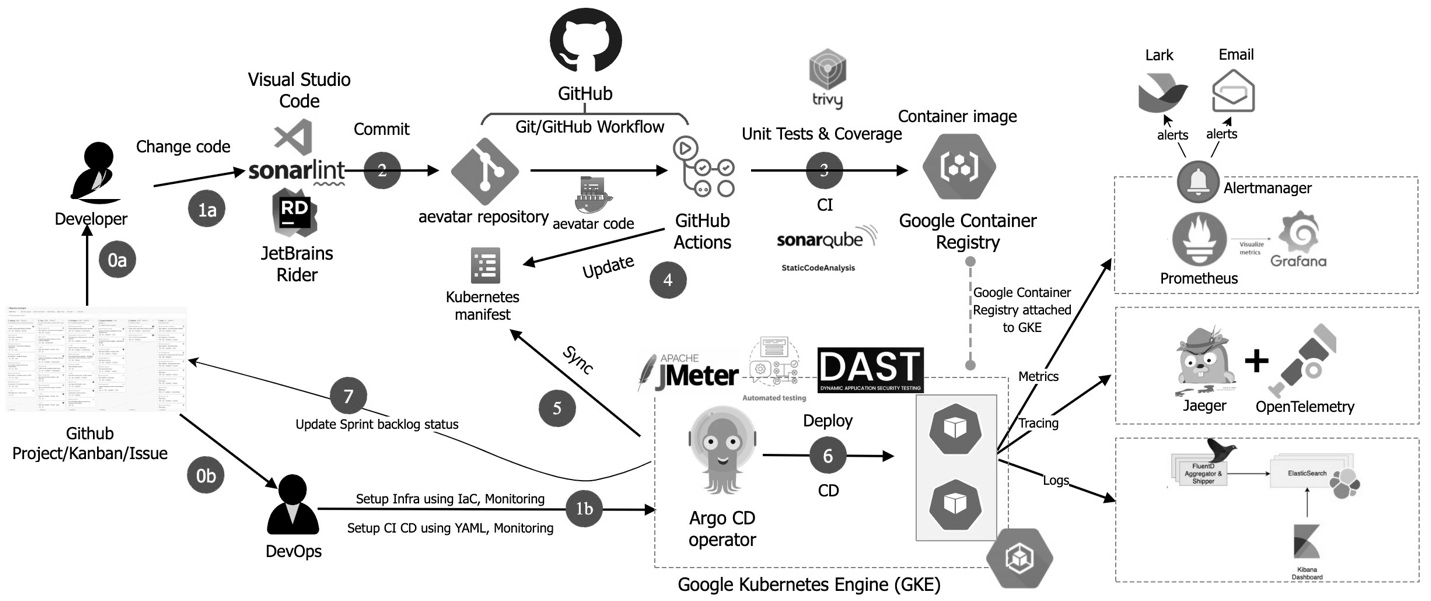

可扩展性 (Scalability)

|

- 利用 Orleans,一个结合了微服务和 Actor 模型的分布式框架,可针对大规模署理网络实现可扩展性和高可用性。

- 基于容器化部署,利用 Kubernetes 实现跨云本领、自动伸缩、高可用性和高并发。

|

- 利用 Node.js,多历程架构,但缺少分布式编程模型。

|

- 依赖于 Photon 或 SpatialOS 之类的游戏专用后端来实现实时性能。

|

用例(Use Cases)

| 为区块链和金融等行业中的通用、可扩展、多范畴逻辑而构建

| 为较小的网页项目和社区驱动的原型开辟而构建

| 为游戏和元宇宙场景(包含通证经济集成)而构建

|

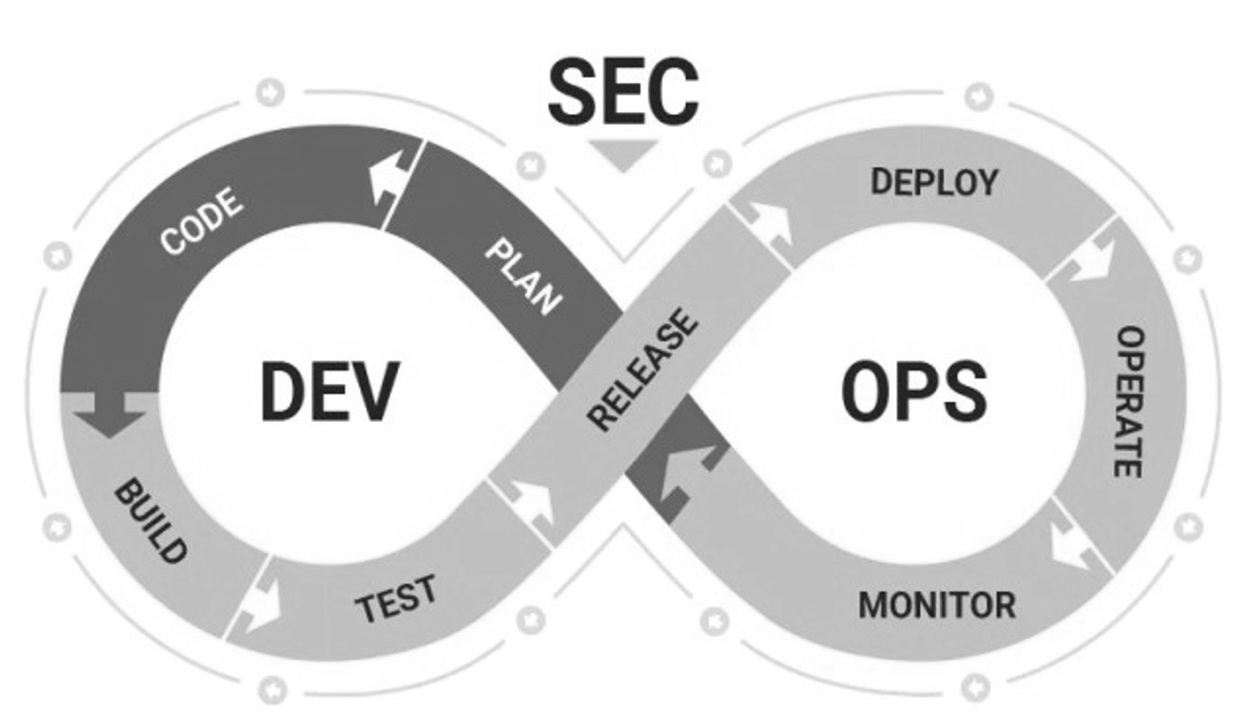

云原生 & DevOps (Cloud Native & DevOps)

| 先辈的云原生 Kubernetes 部署,通过 DevSecOps & GitOps 提供强大的安全性

| 专注于速度,但缺乏广泛的自动化和合规机制

| 专注于性能,但未提供完备的云原生工具

|

维护 (Maintainability)

| Agent-as-a-Service 通过Plugin举行功能迭代,无须用户自己部署服务。优化了对Agent开辟和部署的操纵。

| Supabase 借助其后端即服务(Backend-as-a-Service)平台,为开辟运维提供易用的部署方式

| 未确定 —— 闭源

|

代码获取 (Code Access)

| 开源

| 开源

| 闭源(黑盒)

|

平台集成 (Platform Integrations)

|

|

|

|