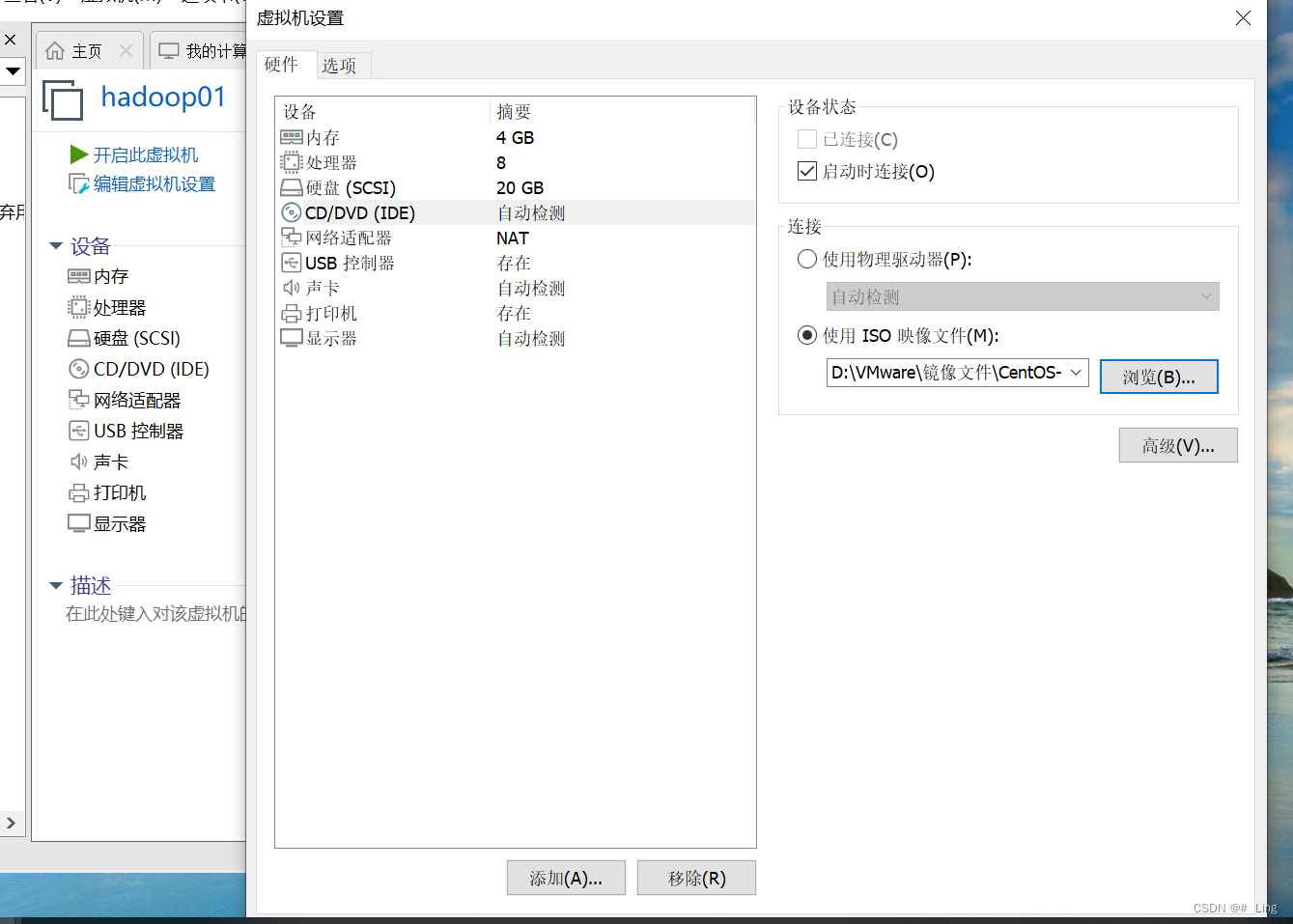

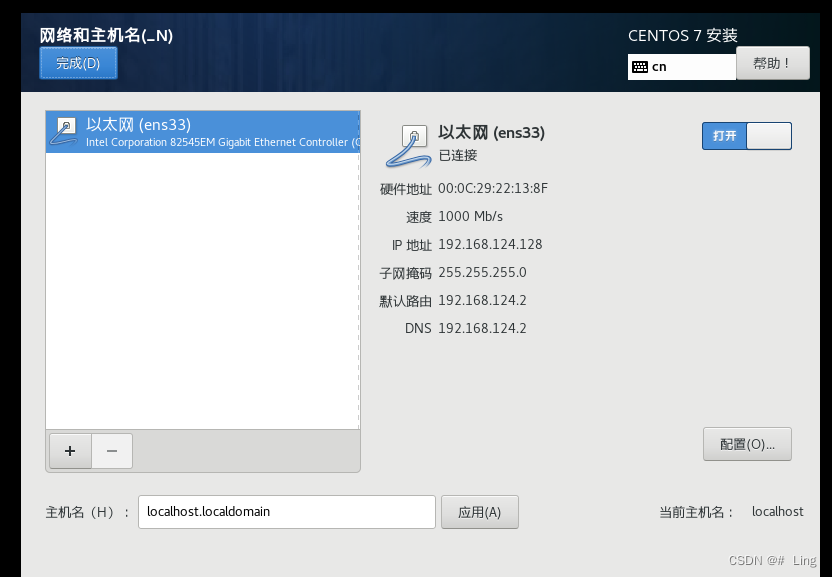

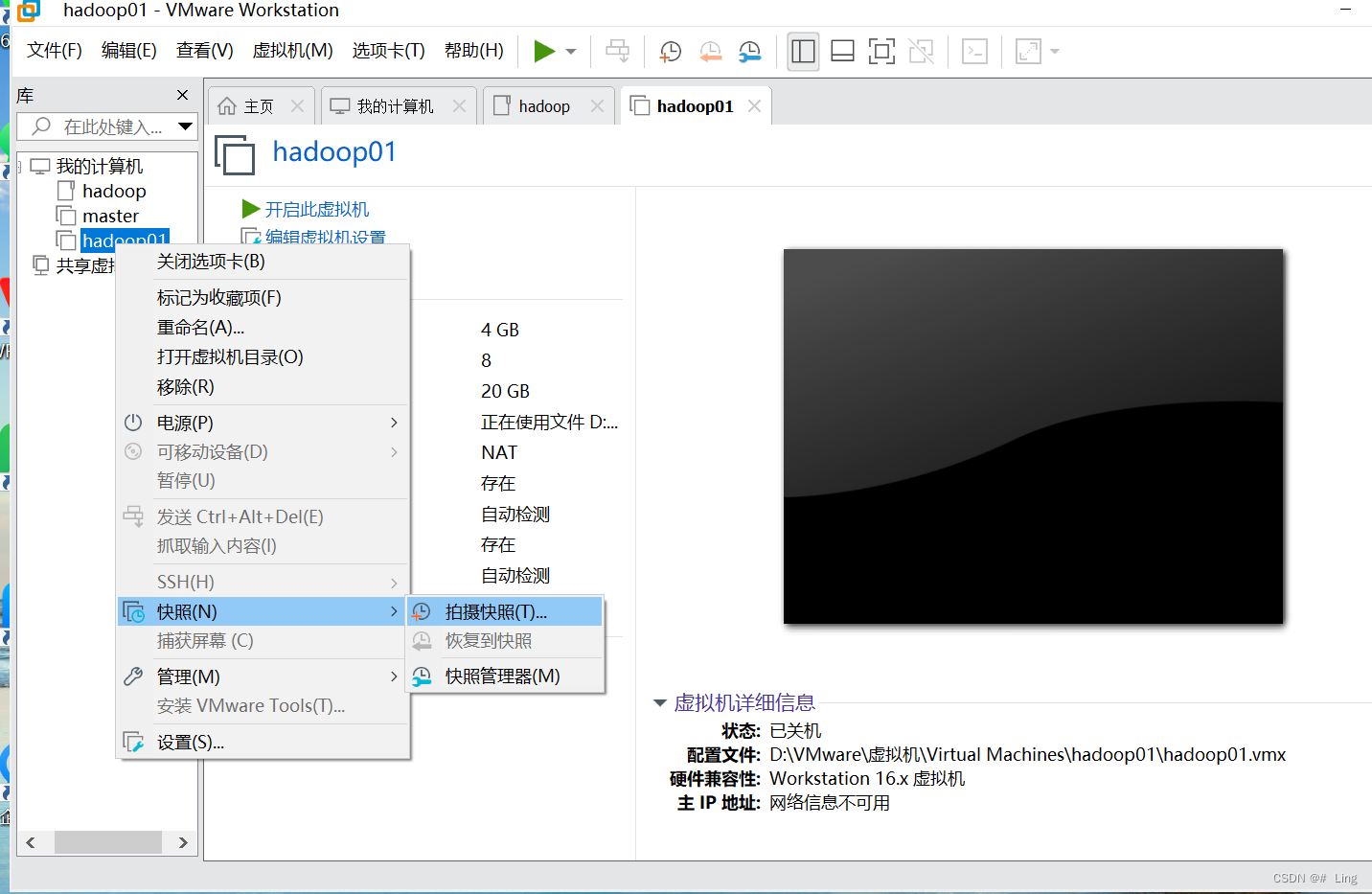

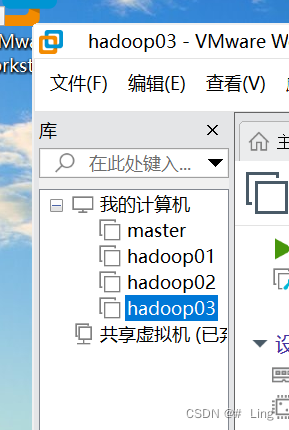

| 主机名 | HDFS | YARN | IP地点 |

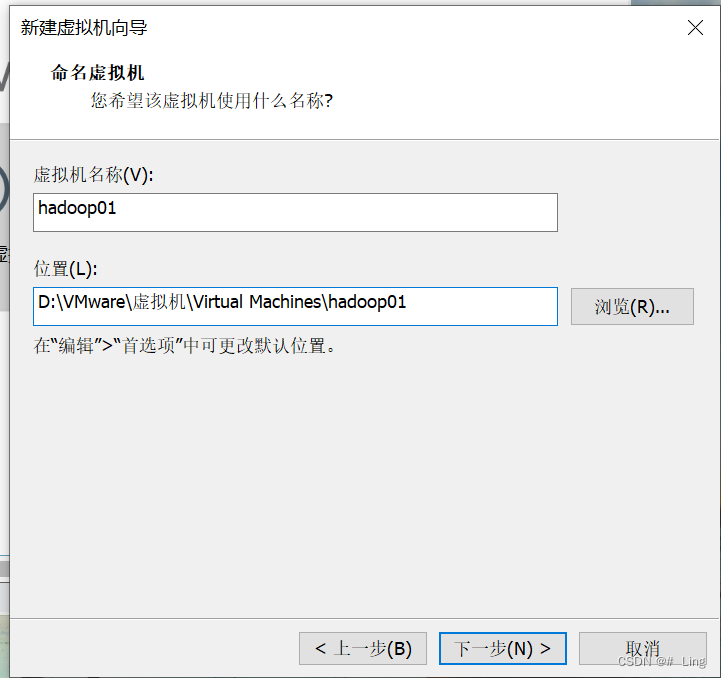

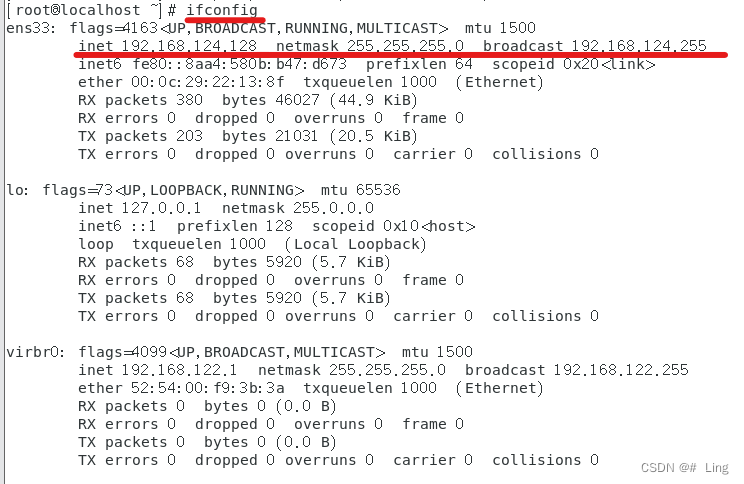

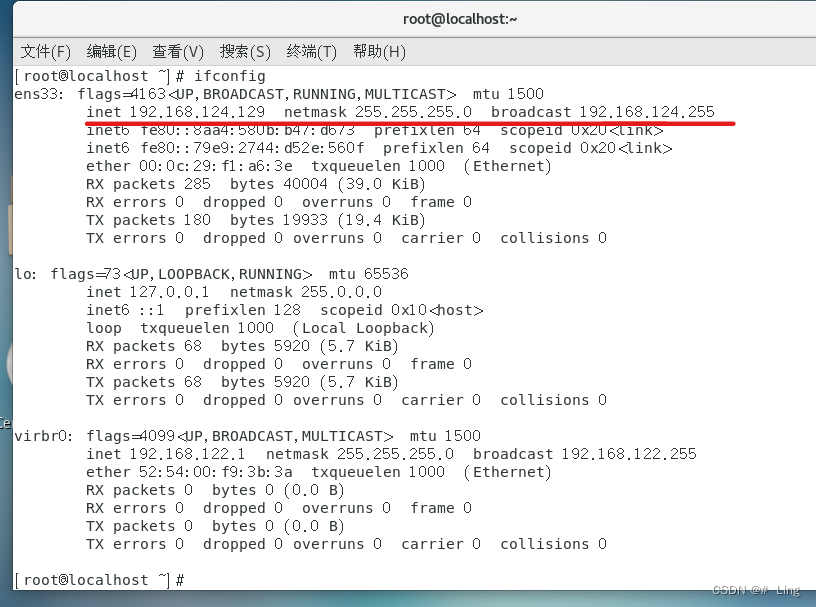

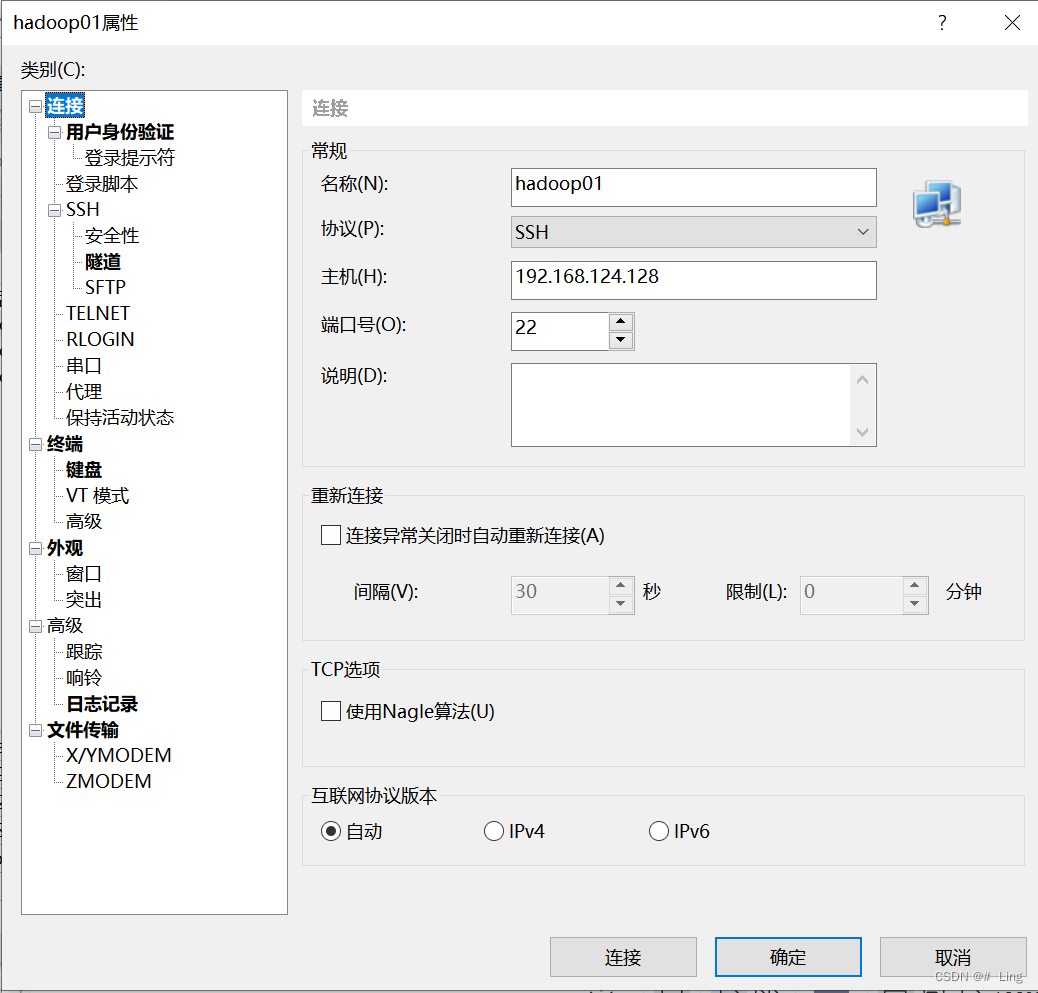

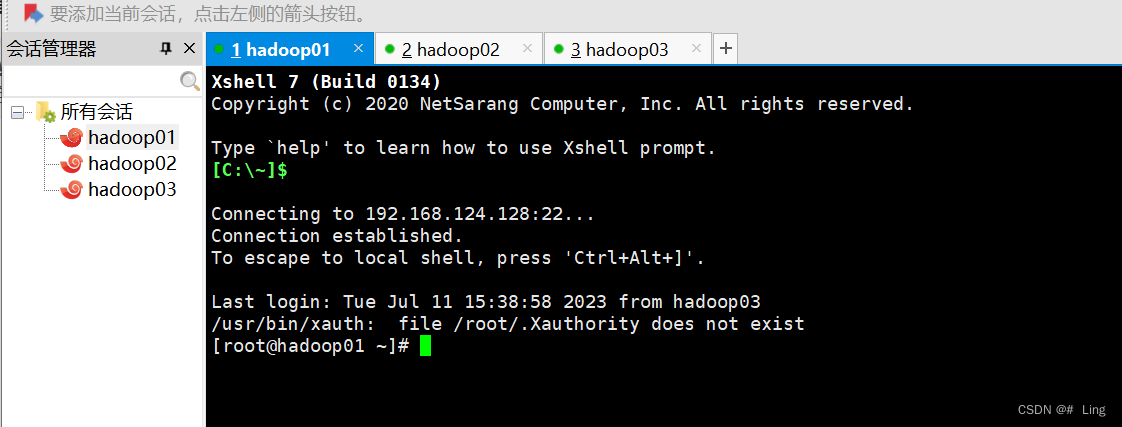

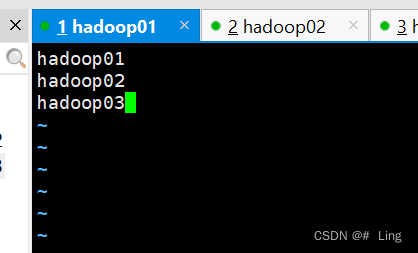

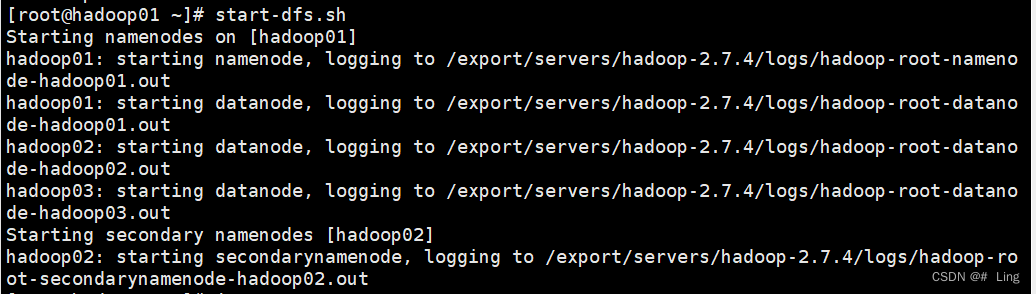

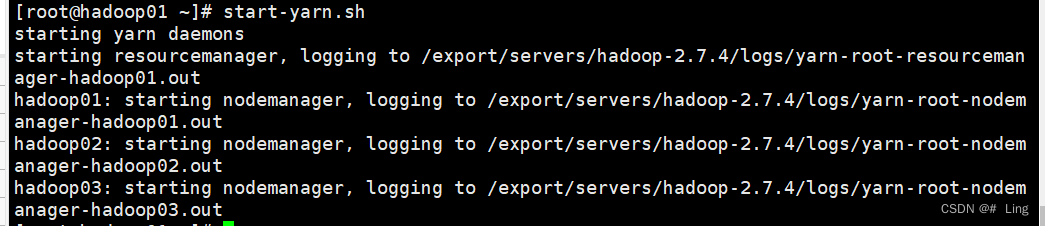

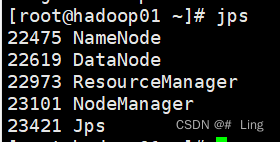

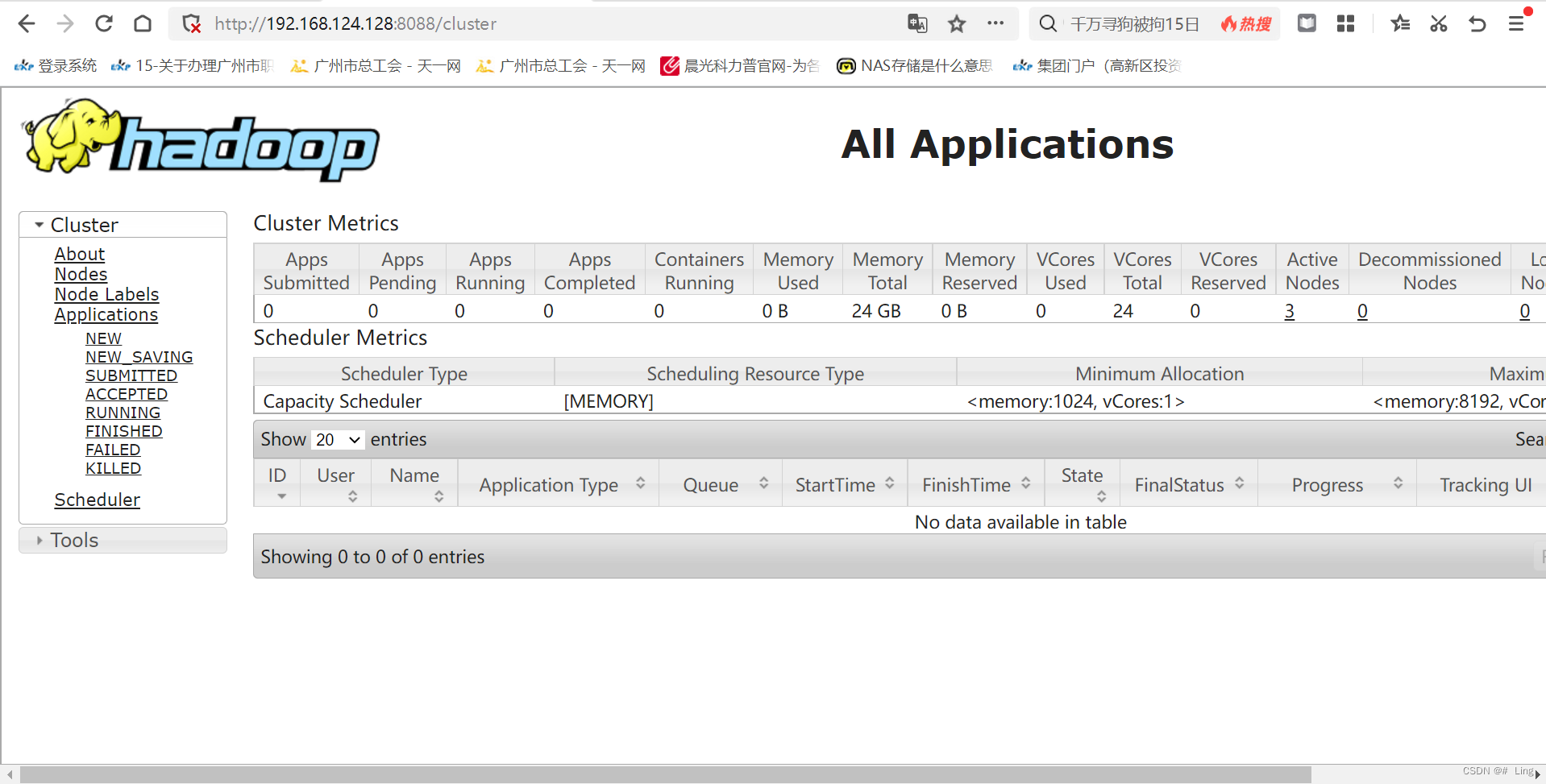

| hadoop01 | NameNode DataNode | ResourceManager NodeManager | 192.168.124.128 |

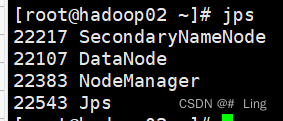

| hadoop02 | SecondaryNameNode DataNode | NodeManager | 192.168.124.129 |

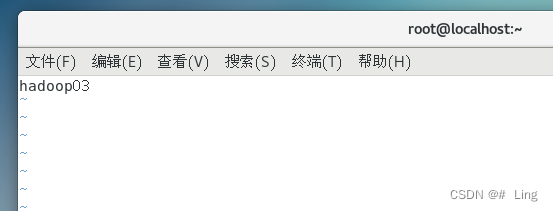

| hadoop03 | DataNode | NodeManager | 192.168.124.130 |

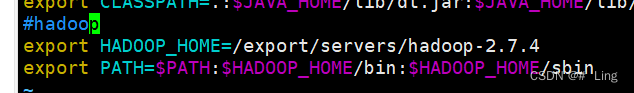

HADOOP_HOME/bin

HADOOP_HOME/bin HADOOP_HOME/sbin

HADOOP_HOME/sbin

| 欢迎光临 IT评测·应用市场-qidao123.com (https://dis.qidao123.com/) | Powered by Discuz! X3.4 |