作者:运维有术星主本日,我将为大家分享,如安在 Kubernetes 集群中手动安装 Kubernetes NFS Subdir External Provisioner 插件。这是一个强大的工具,可以或许实现为 Kubernetes 集群提供自动化的基于 NFS 存储的长期化动态卷管理能力。通过实战演示,您将学会如何将 NFS 作为后端的长期化存储解决方案集成至 Kubernetes 集群。

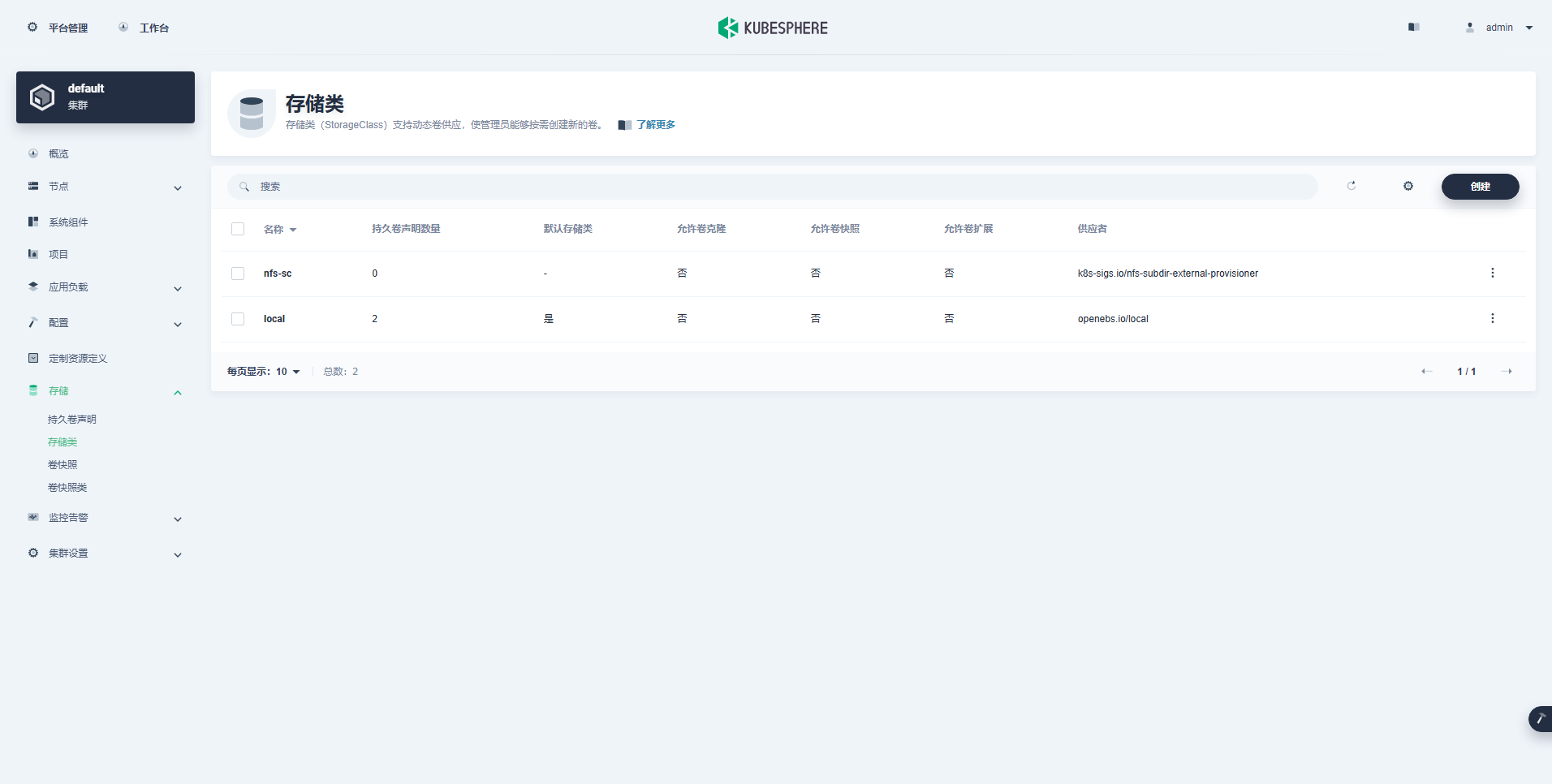

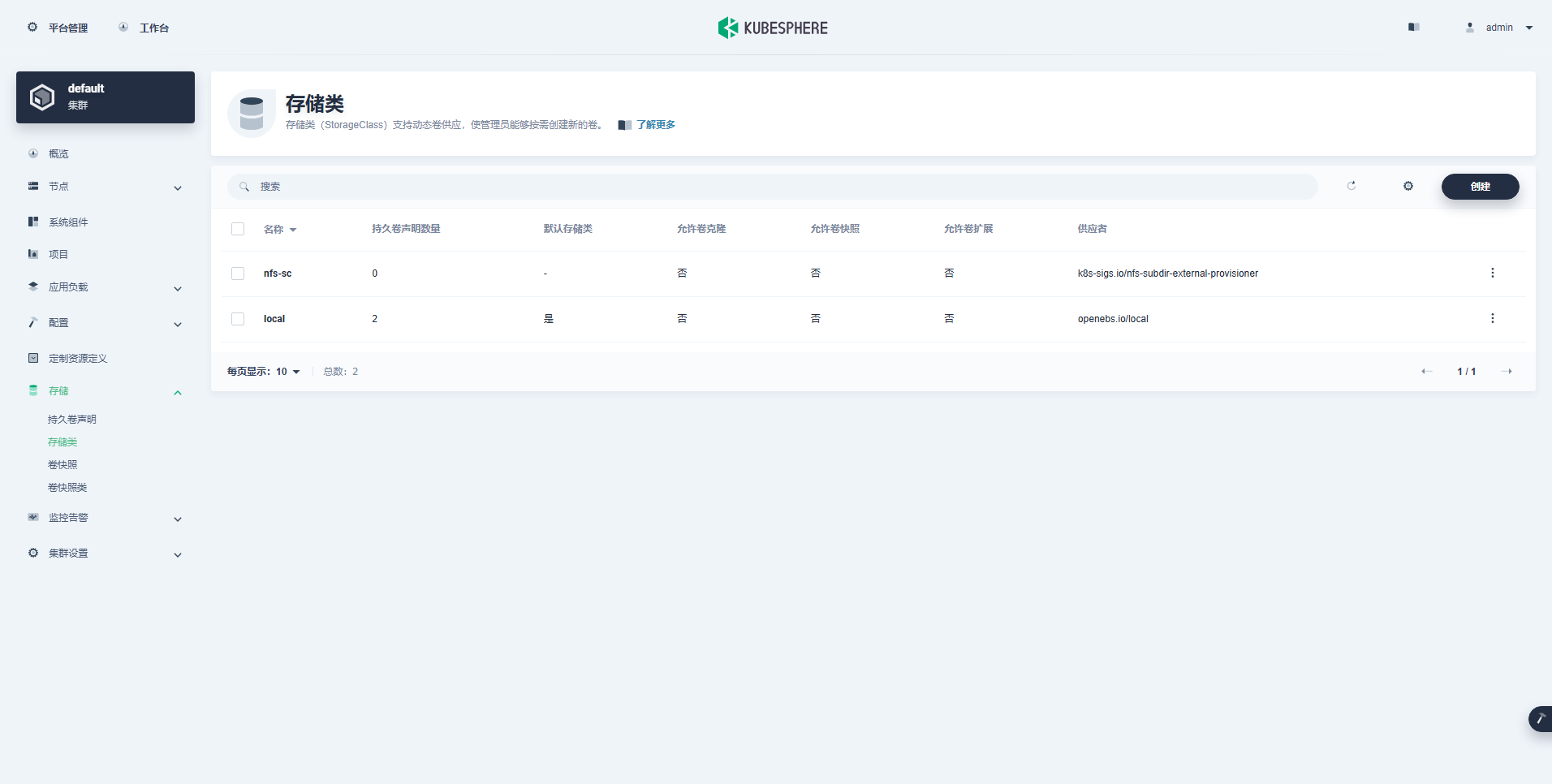

在 Kubernetes 生态系统中,长期化存储扮演着至关重要的角色,它是支撑应用稳定运行的基石。对于那些选择自建 Kubernetes 集群的运维架构师而言,选择合适的后端长期化存储解决方案是一项至关重要的选型决策。后端长期化存储常见的解决方案有 Ceph、GlusterFS、NFS、hostPath,以及这两年新兴起的 Longhorn。当然,技术领域日新月异,另有其他优秀的解决方案我尚未了解。

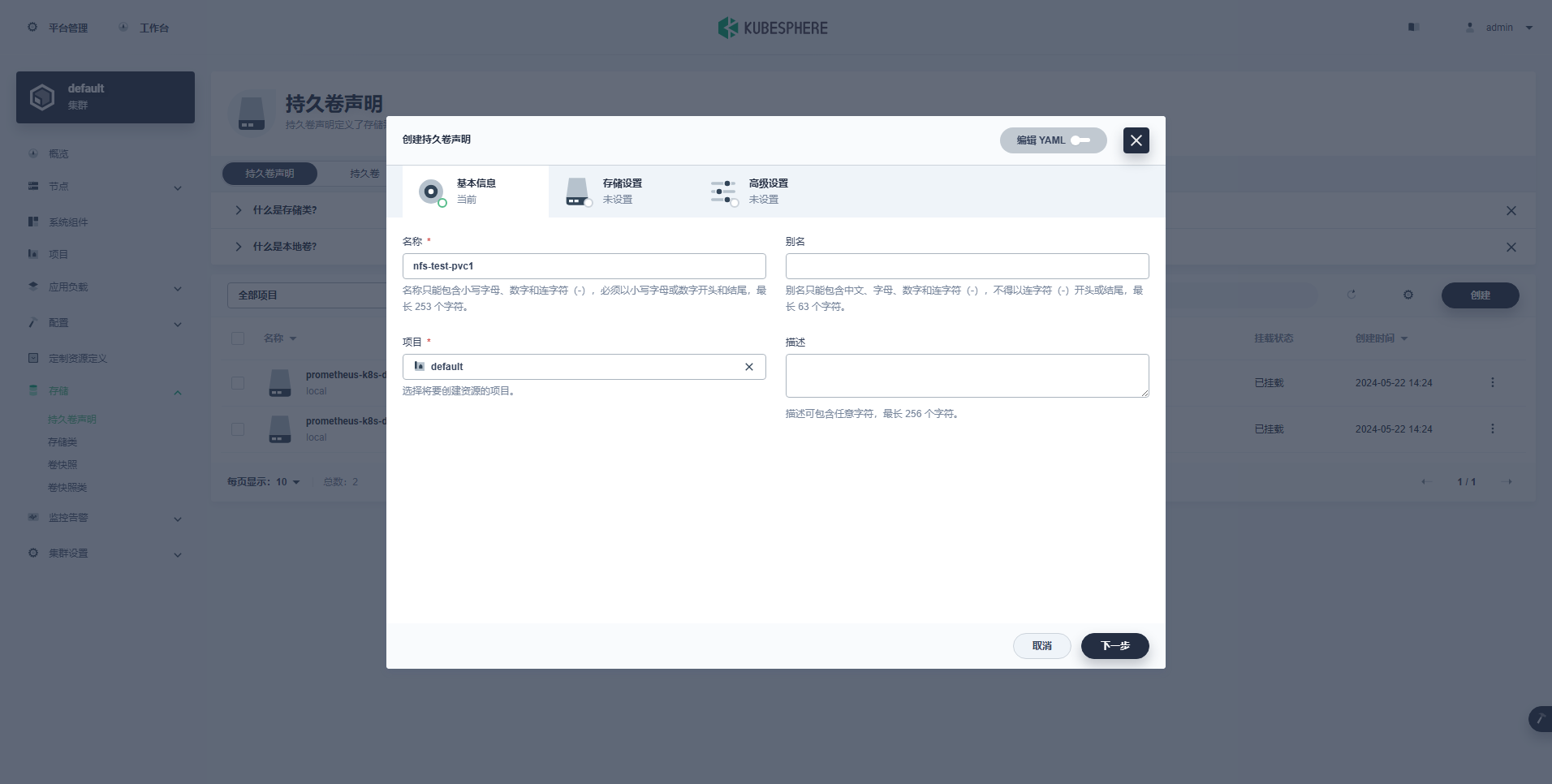

设置说明:

说明: 重要修改内容,用实际 NFS 设置信息更换默认值(受限于篇幅,未展示最终修改后的内容)

说明: 重要修改内容

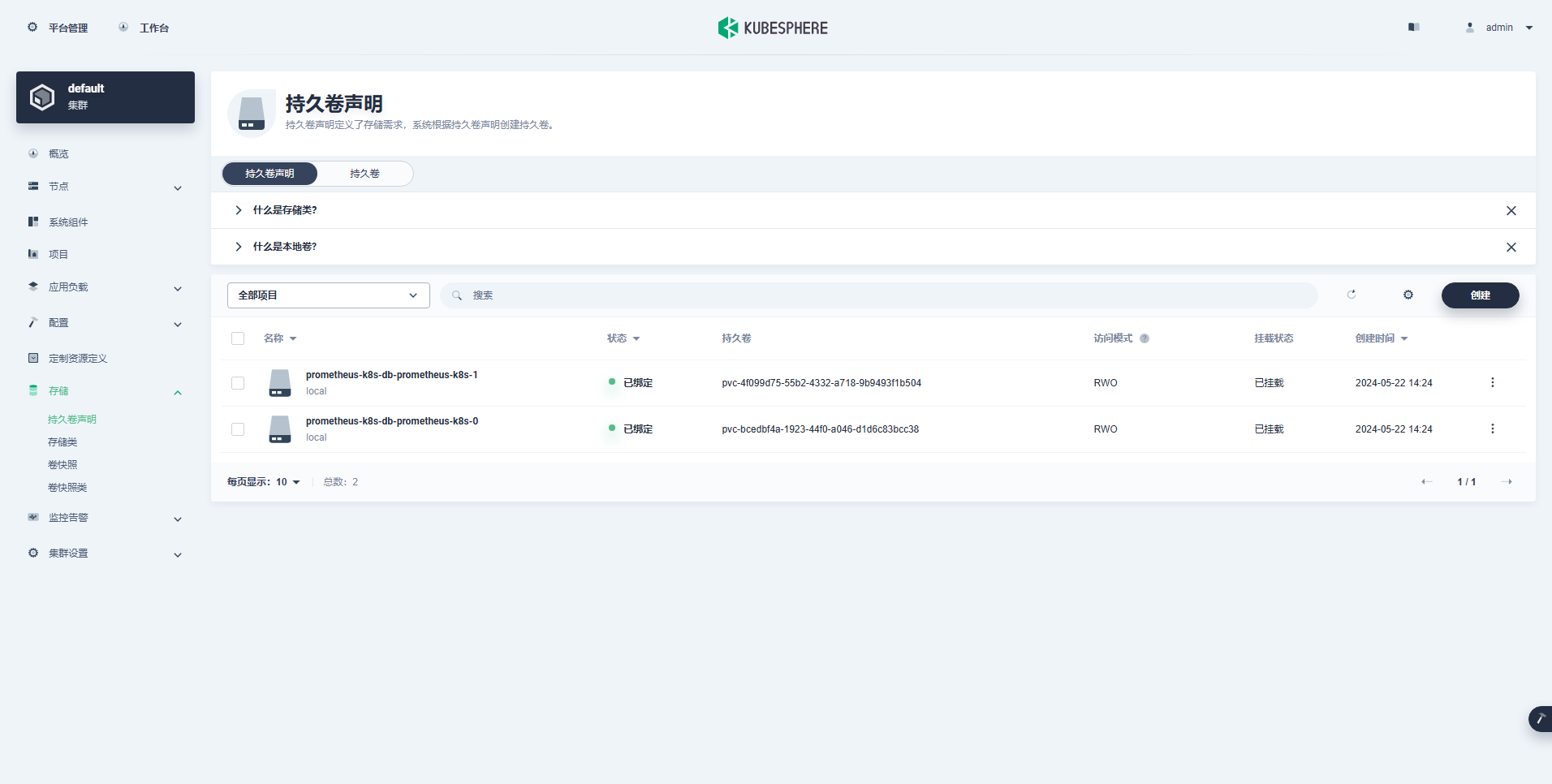

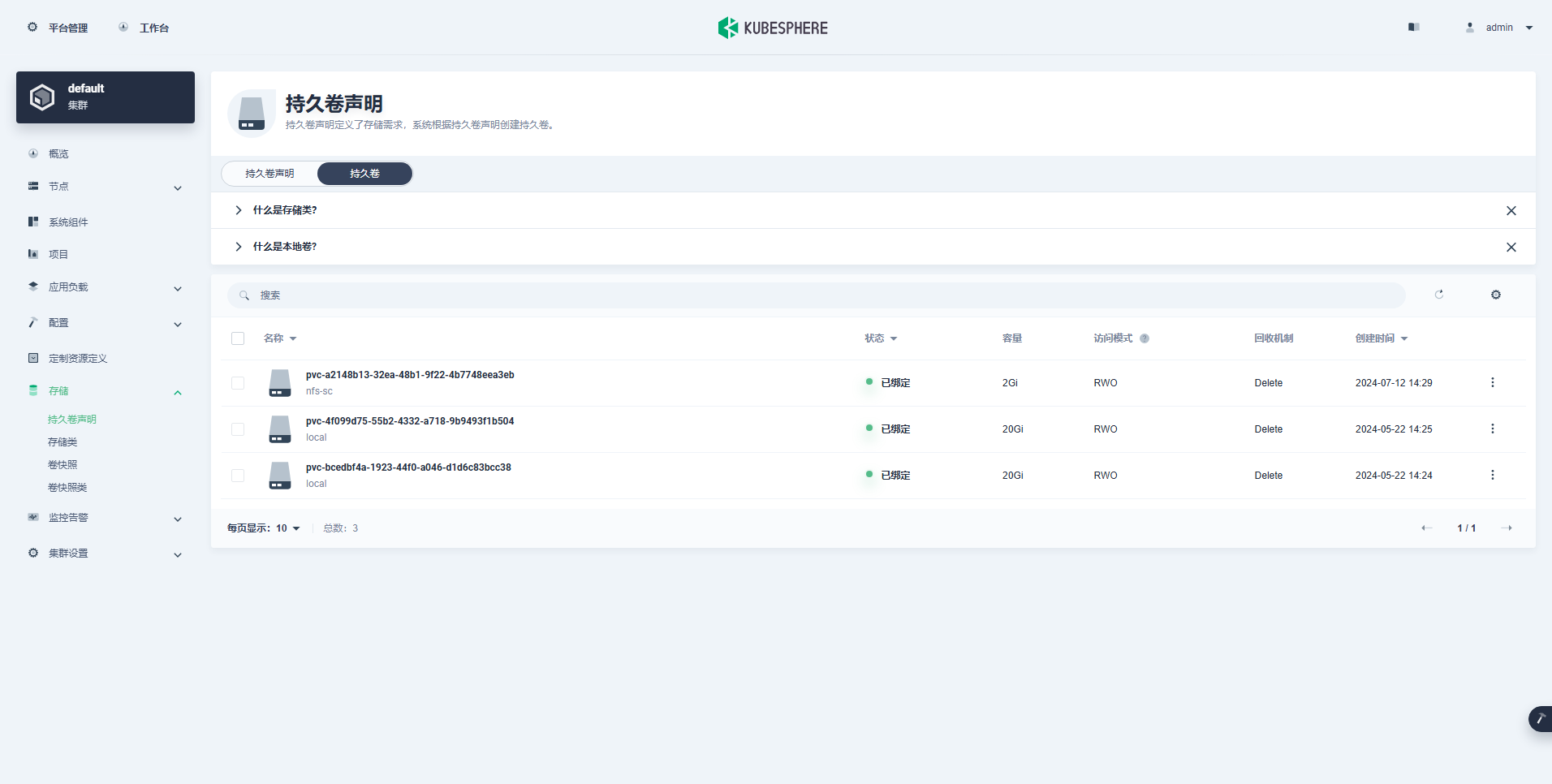

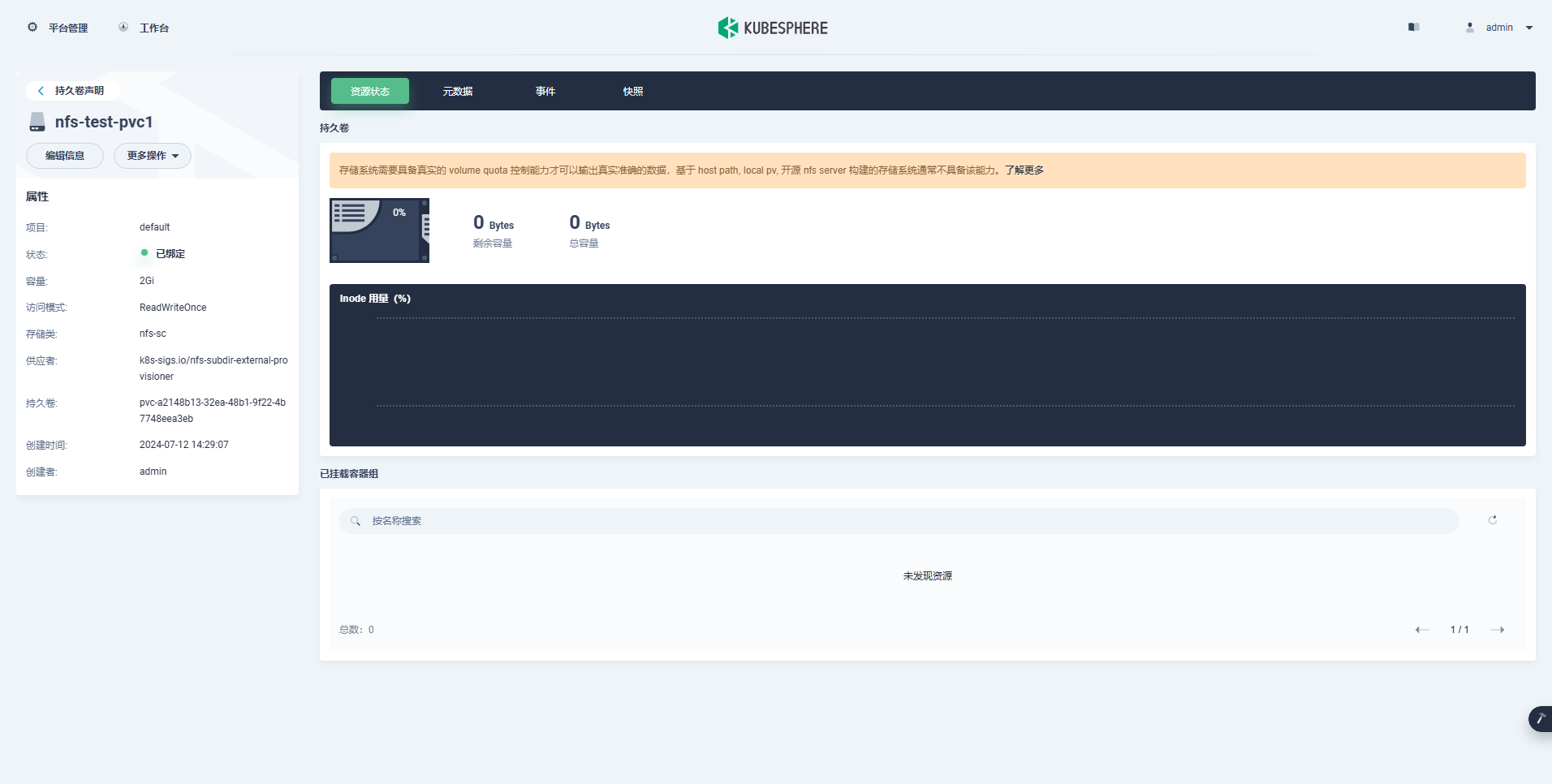

注意: 在输出结果中我们可以看到挂载的 NFS 存储的可用空间为 99.9G,而不是我们 PVC 中分配的 1G。

注意: 实际测试我们写入了 2G 的数据量,已经超过了我们创建的 PVC 1G 的限定。因此,要特别注意,利用 NFS 存储时无法限定存储利用量。4.3 存储节点检察验证

说明: 结果中显示的是默认的 openebs 存储,nfs 相关资源已经删除

免责声明:

本文由博客一文多发平台 OpenWrite 发布!

| 欢迎光临 ToB企服应用市场:ToB评测及商务社交产业平台 (https://dis.qidao123.com/) | Powered by Discuz! X3.4 |