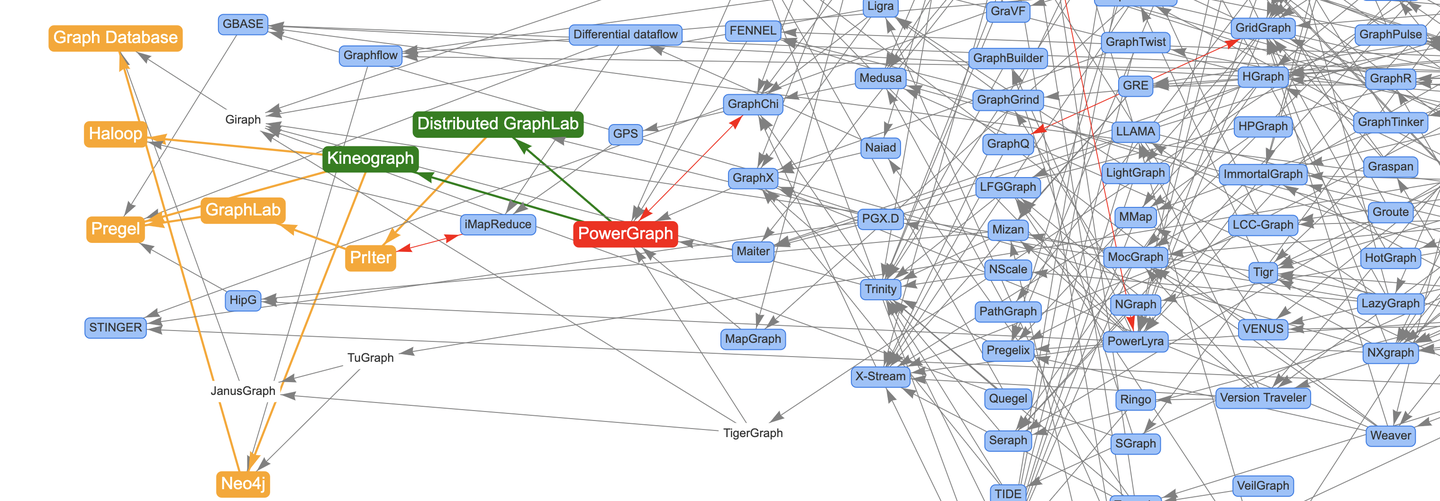

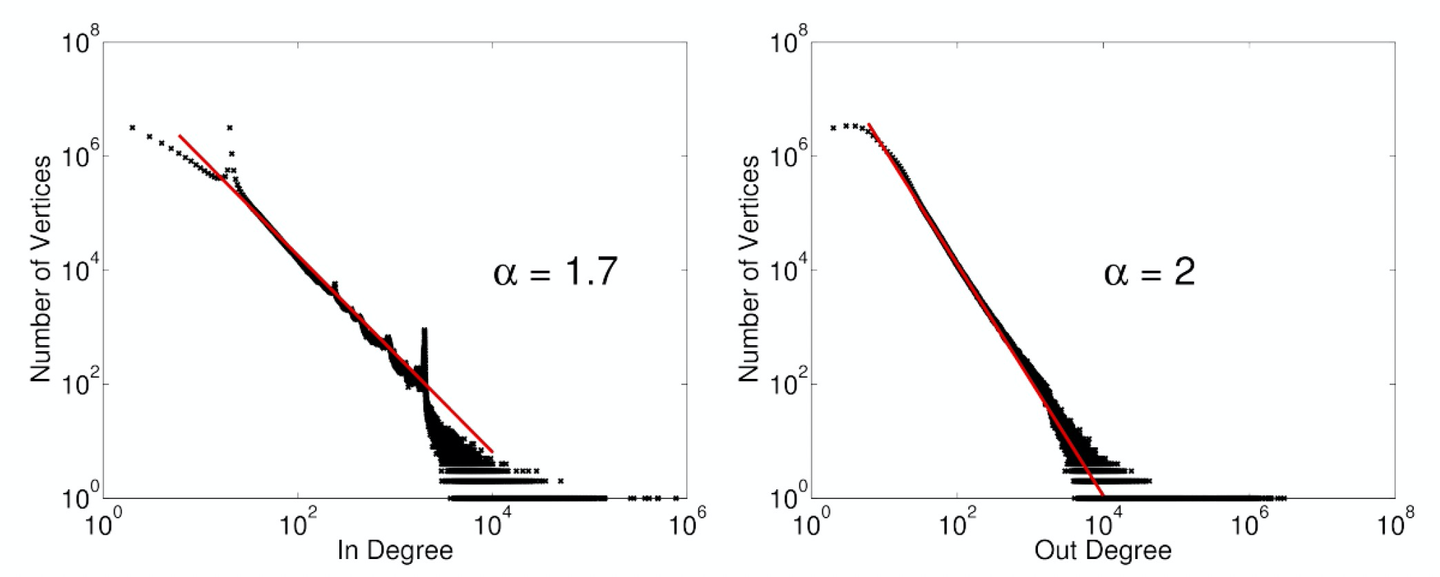

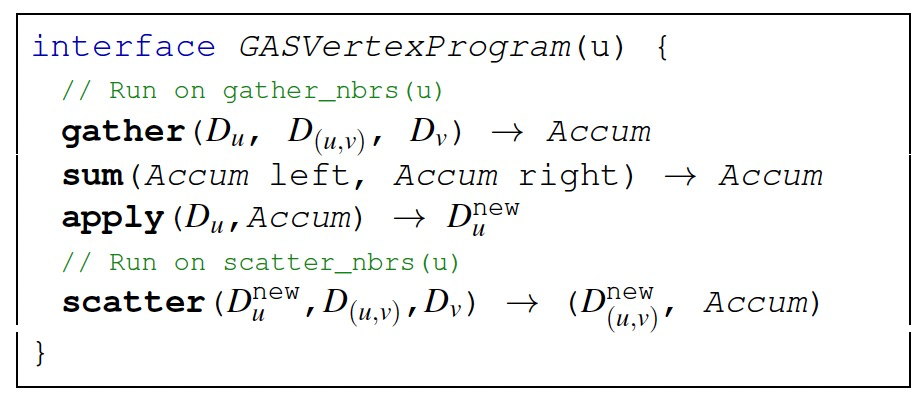

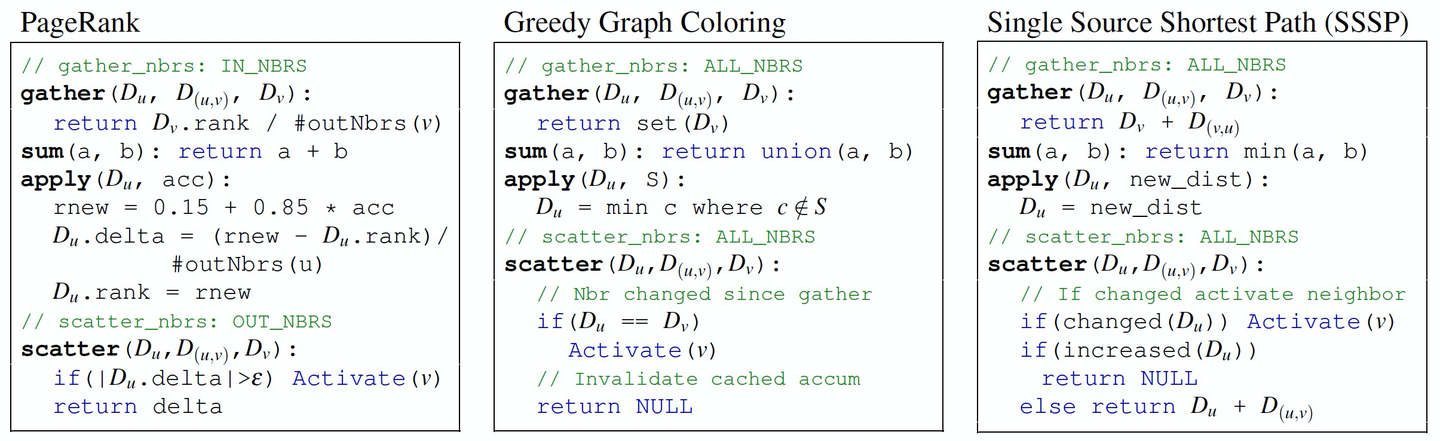

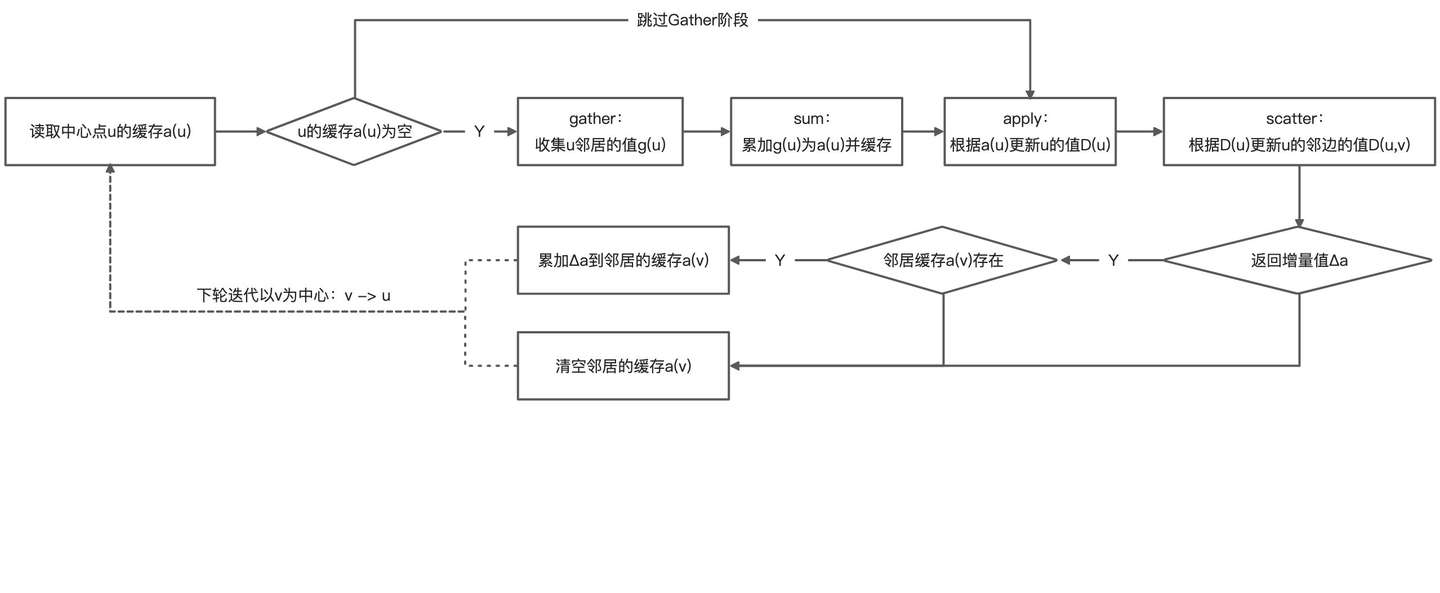

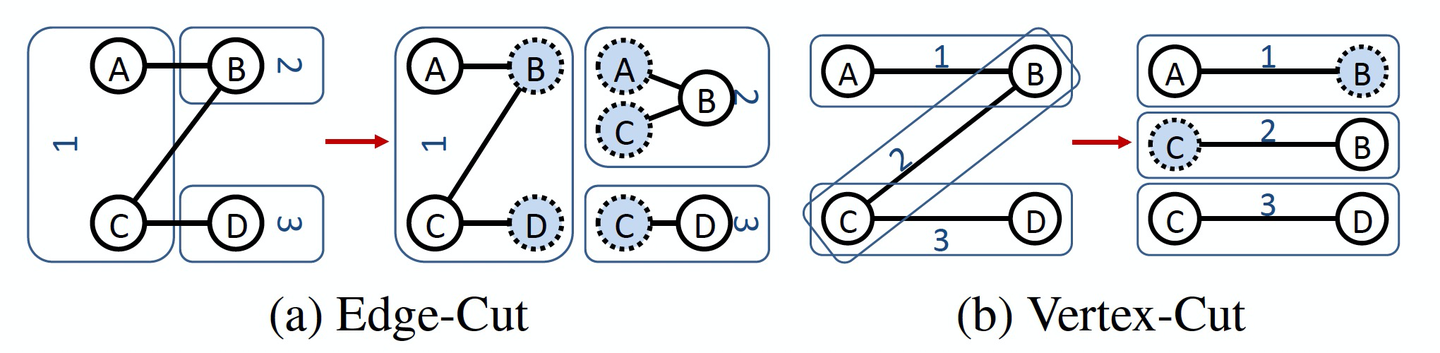

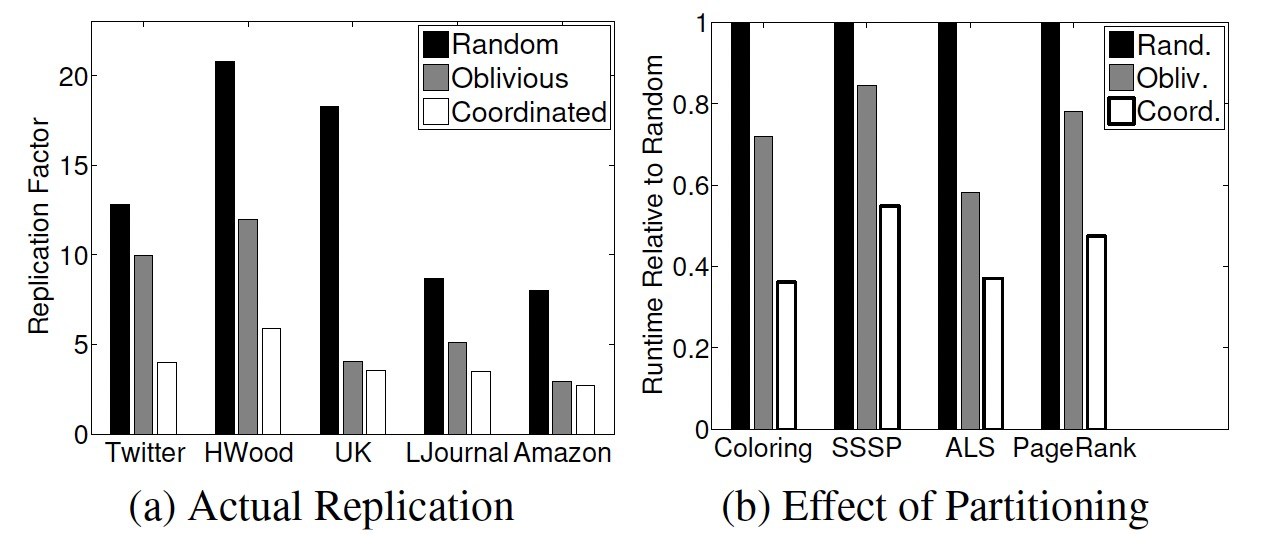

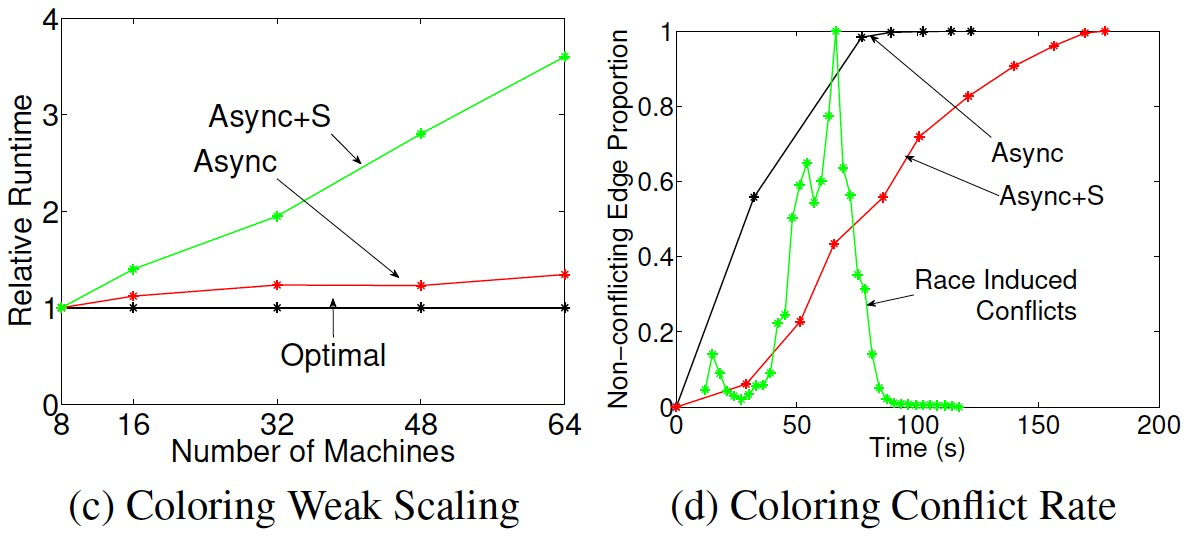

PowerGraph论文:《PowerGraph: Distributed Graph-Parallel Computation on Natural Graphs》上次通过文章《论文图谱当如是:Awesome-Graphs用200篇图系统论文打个样》向各人先容了论文图谱项目Awesome-Graphs,并从Google的Pregel开始解读图计算系统关键论文。这次向各人分享发表在OSDI 2012上的一篇经典图计算框架论文PowerGraph,旨在通过点切分解决图数据幂律分布导致的计算倾斜标题,并提出了区别于Pregel's VC(以点为中央)的GAS(以边为中央)计算框架。

D_{(u,v)}) \leftarrow s(D_u^{new}, D_{(u,v)}, D_v)\)

D_{(u,v)}) \leftarrow s(D_u^{new}, D_{(u,v)}, D_v)\)

| 欢迎光临 ToB企服应用市场:ToB评测及商务社交产业平台 (https://dis.qidao123.com/) | Powered by Discuz! X3.4 |