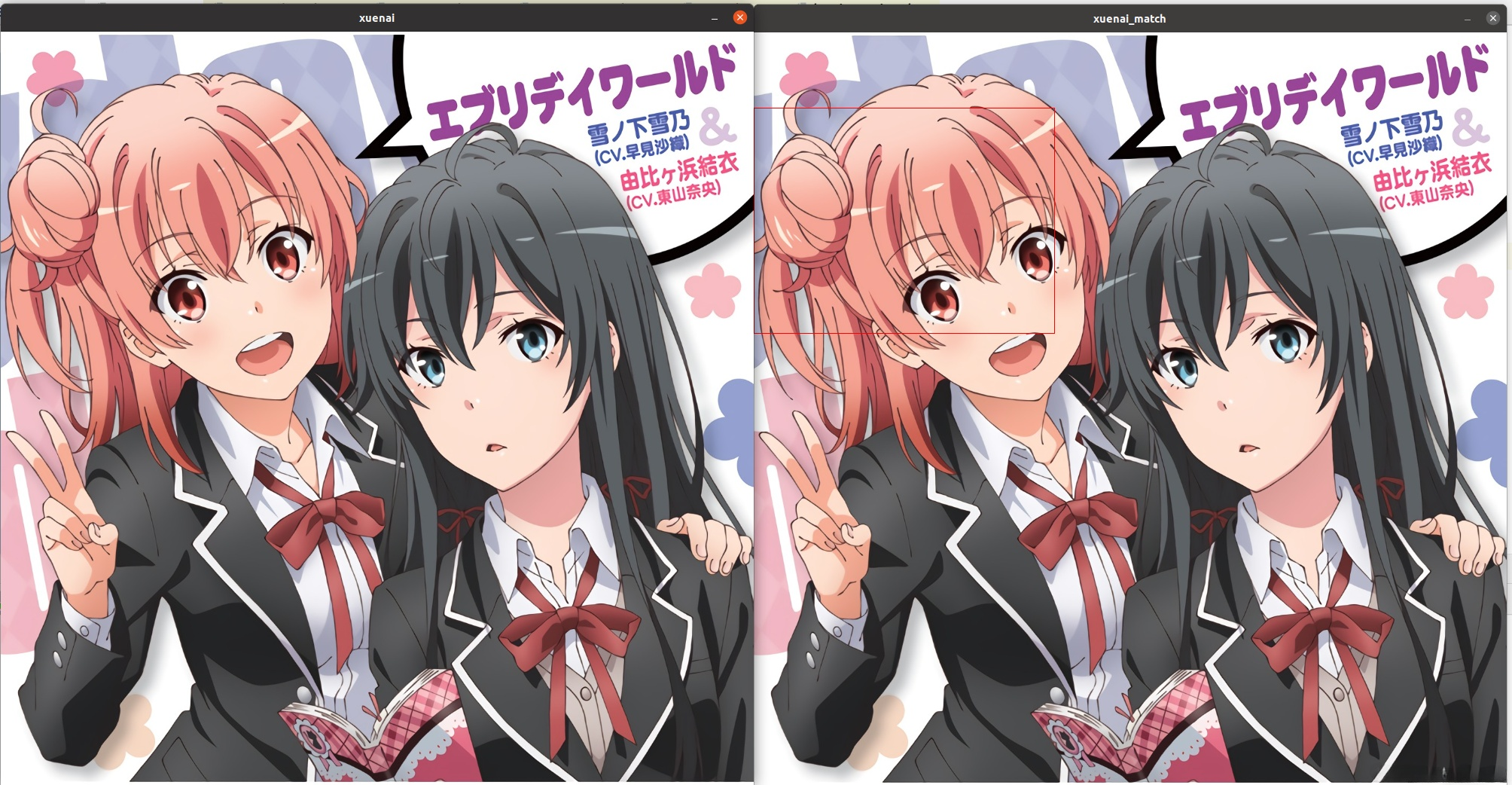

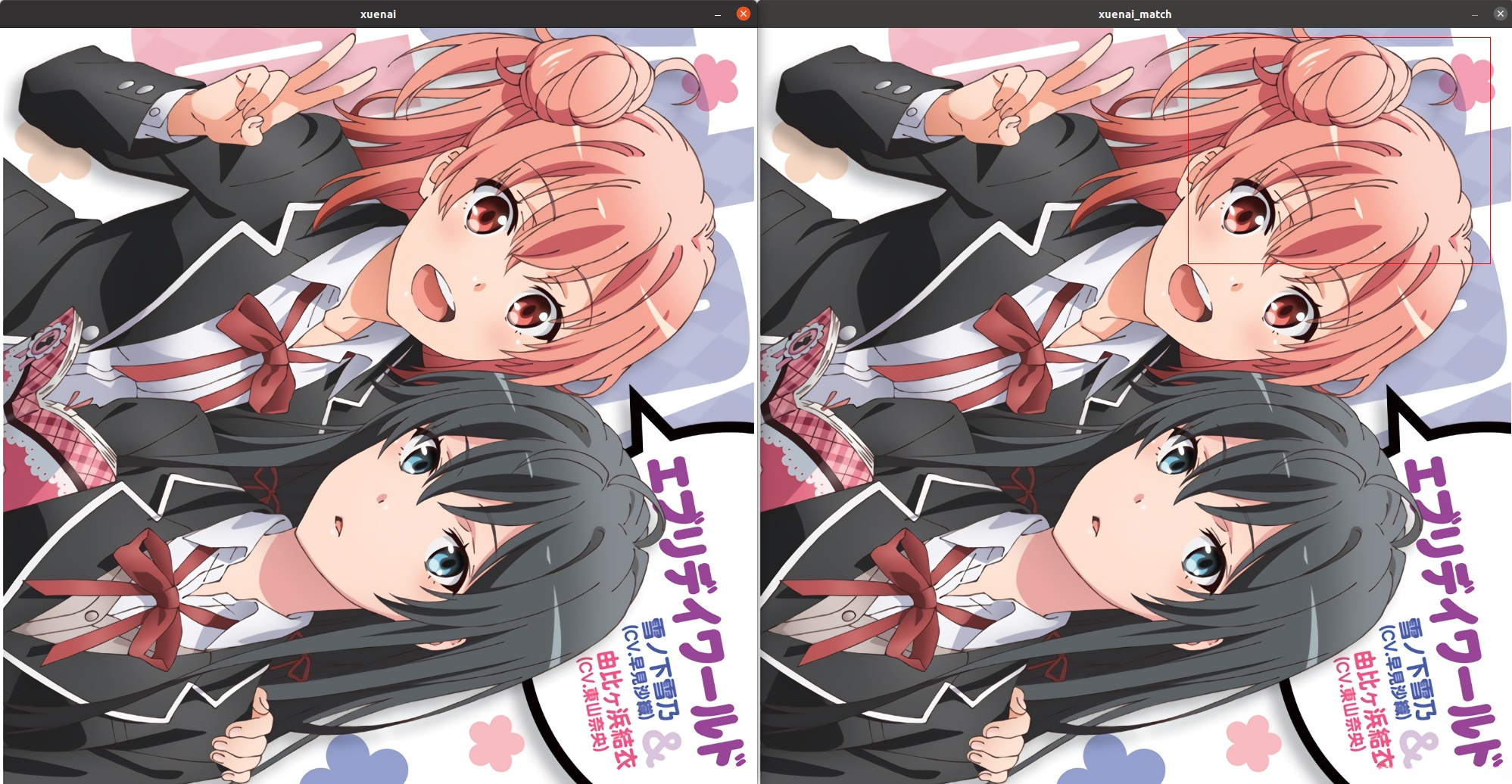

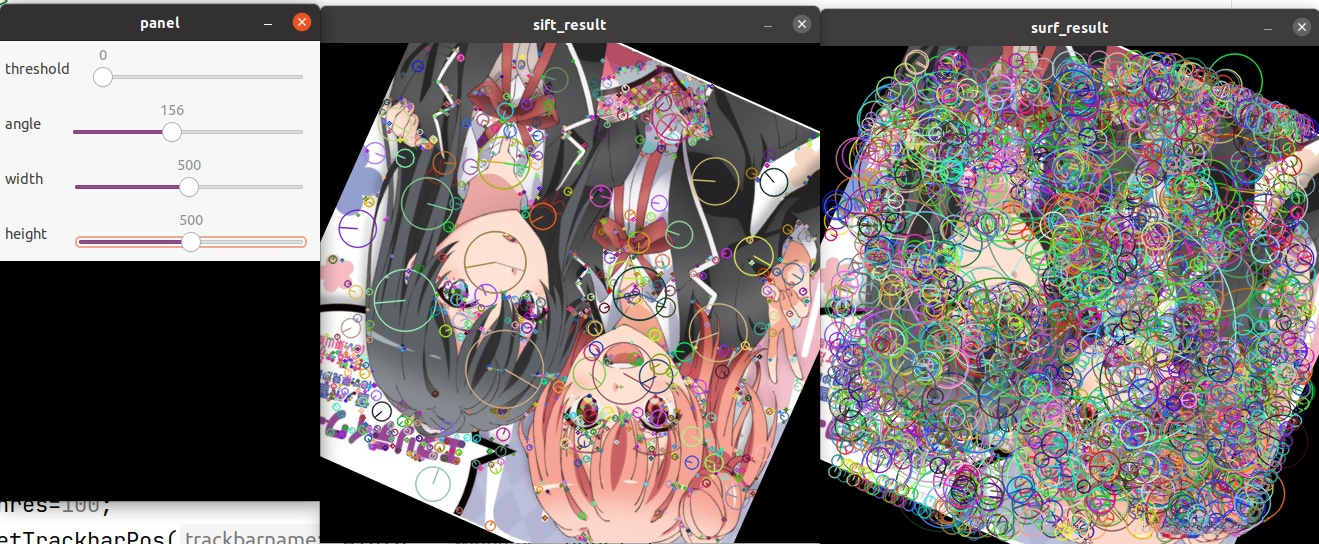

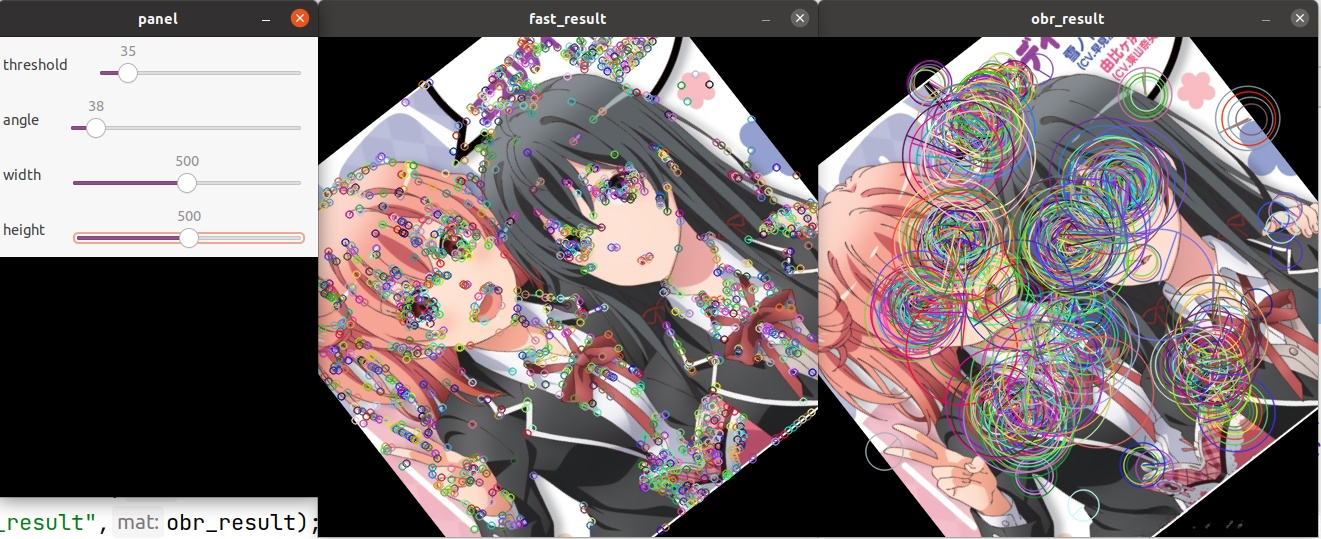

RAW_RICH_KEYPOINTS); drawKeypoints(obr_result,xuenai_ObrKp,obr_result,Scalar::all(-1),DrawMatchesFlags:

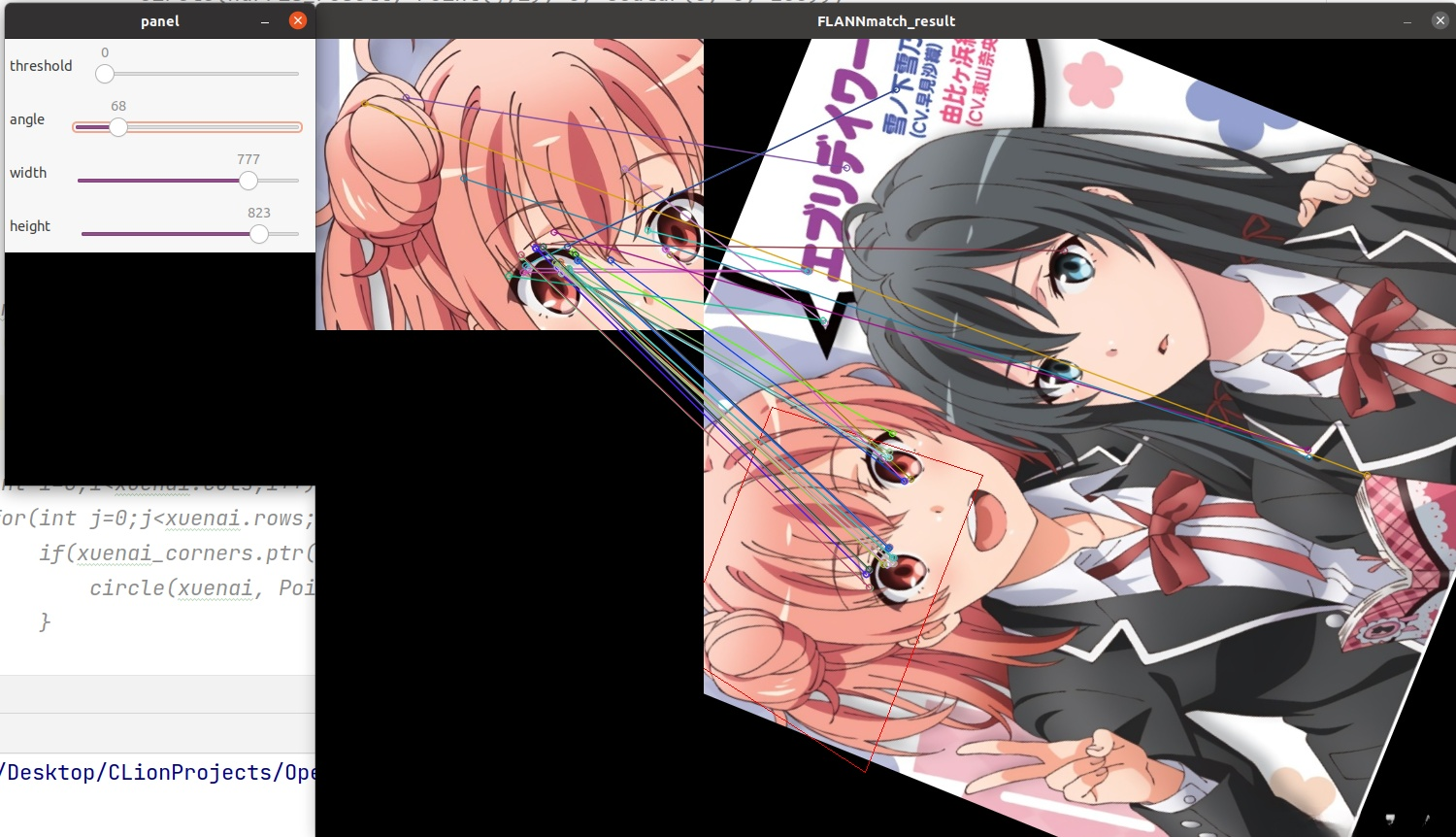

RAW_RICH_KEYPOINTS); drawKeypoints(obr_result,xuenai_ObrKp,obr_result,Scalar::all(-1),DrawMatchesFlags: RAW_RICH_KEYPOINTS); imshow("fast_result",fast_result); imshow("obr_result",obr_result); if (waitKey(0) == 'q')break;}[/code]调整threshold

RAW_RICH_KEYPOINTS); imshow("fast_result",fast_result); imshow("obr_result",obr_result); if (waitKey(0) == 'q')break;}[/code]调整threshold

本文由博客一文多发平台 OpenWrite 发布!

| 欢迎光临 IT评测·应用市场-qidao123.com (https://dis.qidao123.com/) | Powered by Discuz! X3.4 |