ToB企服应用市场:ToB评测及商务社交产业平台

标题: 国产五大模子之一MiniMax 利用国内首个MOE架构 [打印本页]

作者: 玛卡巴卡的卡巴卡玛 时间: 2024-8-24 09:16

标题: 国产五大模子之一MiniMax 利用国内首个MOE架构

阿里被曝2024年面向AIGC的第二次大手笔投资来了——加注大模子赛道独角兽Minimax,领投至少6亿美元。

彭博社消息称,新一轮融资或将使MiniMax估值超25亿美元。现在阿里和红杉已承诺将到场本轮融资,其余跟投者还在洽谈中,相关条款大概会有所调整。除阿里外,腾讯、米哈游、IDG资本、高瓴都曾投资过。当前估值达25亿美元。

Minimax是谁?

MiniMax 成立于 2021 年 12 月,由商汤科技前副总裁闫俊杰创立。公司致力于开辟先进的人工智能技术,特别是在大型语言模子(LLMs)领域。其技术焦点是开辟的 ABAB 大模子,这是一个基于 MoE(Mixture of Experts)架构的模子,旨在通过集成多个专家网络来进步模子的扩展性和效率。MoE 架构允许模子在处理复杂任务时拥有更大的参数量,同时保持较高的盘算效率。MiniMax 的 ABAB6 模子是国内首个接纳 MoE 架构的大语言模子,它在单元时间内可以或许练习更多的数据,明显提升了模子的性能和效率。MiniMax 提供多种基于其大模子的产品与服务,包括但不限于 MiniMax API 开放平台、海螺 AI 和星野等。这些产品服务于谈天对话、内容天生、语音合成、情感分析等多种场景,满足不同行业和应用的需求。MiniMax 不断推动其大模子技术的发展,比方,其 ABAB6 模子在处理复杂任务方面进行了明显改进,提供了更好的多模态明白和多语言支持。

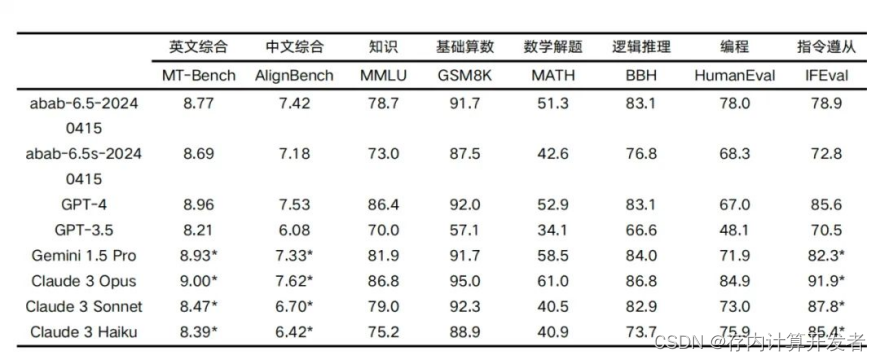

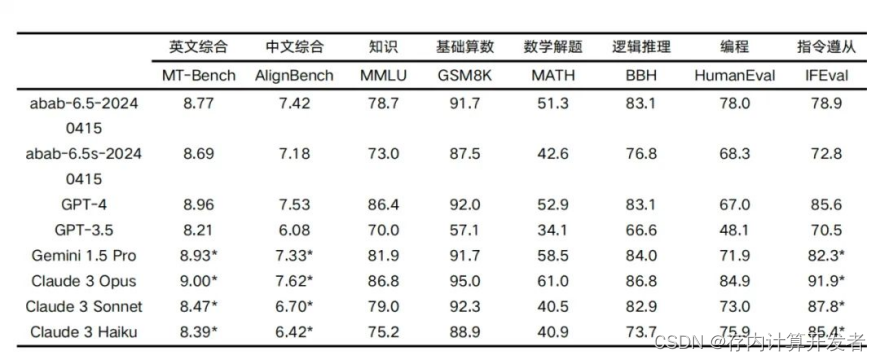

Minimax利用的大语言模子架构是国内发布的首个MoE架构,全称专家混淆(Mixture-of-Experts),是一种集成方法,其中整个题目被分为多个子任务,并将针对每个子任务练习一组专家。MoE 模子将覆盖不同学习者(专家)的不同输入数据。2024 年 4 月 17 日,MiniMax 正式推出abab 6.5 系列模子。abab 6.5 系列包含两个模子:abab 6.5 和 abab 6.5s。abab 6.5 包含万亿参数,支持 200k tokens 的上下文长度;abab 6.5s 跟 abab 6.5 利用了同样的练习技术和数据,但是更高效,支持 200k tokens 的上下文长度,可以 1 秒内处理近 3 万字的文本。在各类焦点能力测试中,abab 6.5开始接近 GPT-4、 Claude-3、 Gemini-1.5 等天下上最领先的大语言模子。

焦点能力测试

我们用业界标准的开源测试集来测试两个模子,在知识、推理、数学、编程、指令遵从等维度上和行业领先的语言模子进行了对比。

在 891 次测试中,abab 6.5 均能精确答复。

MoE架构

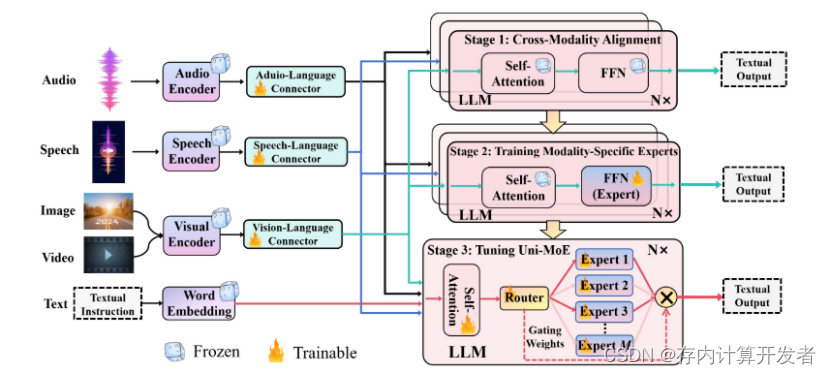

由于练习和摆设大型模子造成的庞大开销,研究人员不停致力于探索利用混淆专家(MoE)架构来进步大型模子的效率。这在大型模子中尤为明显,MoE通过选择性激活不同的网络组件,优化盘算资源并进步性能。在这方面的开创性工作可以在GShard模子中看到[42],它为大规模多语种语言模子引入了MoE的利用,在翻译任务中展示了相称大的改进。Switch Transformers[22]进一步完善了这个概念,通过扩展MoE方法,在视觉明白上实现了亘古未有的模子大小和练习效率。此外,BASE Layers[43]探索了将MoE集成到来自变换器的双向编码器表现中,进一步突显了MoE增强语言明白任务的潜力。MoE在天生模子中的应用也得到了探索,其中GLaM[44]是一个明显的例子,展示了MoE处理多样化和复杂天生任务的能力。在本文中,我们主要探索利用MoE架构构建同一的大型多模态模子。模子大小和性能可以在不增长盘算需求的环境下得到增强。

图 2 展示了设计的 Uni-MoE 的示意图,展示了其全面的设计,包括用于音频、语音和视觉的编码器以及各自的模态毗连器。这些毗连器的作用是将各种模态输入转换为同一的语言空间。然后,我们在焦点 LLM 块内集成了 MoE 架构,这对于进步练习和推理过程的效率至关重要,因为只激活部分参数。这是通过实行稀疏路由机制实现的,如图 2 底部所示。Uni-MoE 的整个练习过程被分为三个不同的阶段:跨模态对齐、练习模态特定专家和利用多样化的多模态指令数据集调整 Uni-MoE。在接下来的小节中,我们将详细探究 Uni-MoE 的复杂架构和渐进式练习方法。

为了发挥不同专家的独特能力,进步多专家协作的效率,并增强整个框架的泛化能力,我们为Uni-MoE的逐步发展引入了一种渐进式练习计谋。算法1概述了旨在实现集成基于MoE的MLLM架构的全面三阶段练习协议。在随后的陈述中,我们将详细说明每个练习阶段的目标和详细内容。

Uni-MoE练习过程

第一阶段:跨模态对齐。在初始阶段,我们的目标是建立不同模态和语言之间的毗连。我们通过构建毗连器来实现这一目标,这些毗连器将各种模态数据转换为语言空间中的软标记。这里的主要目标是最小化天生熵损失。如图2的上半部分所示,LLM被优化以天生跨模态输入的形貌,只有毗连器接受练习。这种方法确保了所有模态在同一的语言框架内无缝集成,便于LLM相互明白。

第二阶段:练习模态特定专家。这一阶段集中于通过针对特定跨模态数据的专门练习来发展单模态专家。目标是进步每个专家在其各自领域内的熟练程度,从而进步MoE系统在多样化多模态数据上的团体性能。同时保持天生熵损失作为主要练习指标,我们定制FFN以更密切地与目标模态的特性对齐。

第三阶段:调整Uni-MoE。最后阶段涉及将第二阶段中调整过的专家权重集成到MoE层中。然后,我们继续利用混淆多模态指令数据共同微调MLLM。练习进程的进展,如损失曲线所示,反映在图3中。比较MoE配置之间的分析显示,在第二阶段颠末精炼的专家实现了更快的收敛,并在混淆模态数据集上显示出更强的稳固性。此外,在涉及复杂混淆模态数据的场景中,包括视频、音频、图像和文本,接纳四个专家的模子显示出比两个专家的模子更低的损失变异性和更同等的练习性能。与利用辅助平衡损失相比,Uni-MoE显示出更好的收敛性,后者导致团体练习损失颠簸,并没有显示出明显的收敛。

本次练习通过集成混淆专家【MoE】架构来扩展大型多模态模子的能力,通过新的三阶段的练习方式,专门用于进步uni-moe在多模态练习中的稳固性能和泛化性能,优于配备相同配置的传统MoE架构。

存内盘算:

MoE模子是当前深度学习和人工智能研究的前沿领域之一,多模态大模子发展除了模子架构不断优化以提升模子处理能力以及效率,算力架构的优化对深度学习和人工智能的发展至关重要,存内盘算架构真正做到存算融合,在存储单元内实现盘算的模式相较于传统冯诺伊曼架构,减少了数据往返搬运,算力提升20X,尤其适应大规模的并行盘算如深度学习。

知存科技凭借率先量产商用的领先技术实力,成为环球存内盘算领域的佼佼者。知存科技成立于2017年,由研发出环球首颗支持多层神经网络存内盘算芯片的郭昕婕博士担当首席科学家。2022年,知存科技WTM2101芯片正式推向市场,赋能百万级终端实现AI能力的提升和应用的推广,成为环球首颗大规模量产商用的存内盘算芯片。

AI期间,存内盘算超越摩尔,将成为人工智能期间的新型算力架构。

总结:

国产大模子齐头并进的当下,在单元时间内,提升模子的处理能力以及效率,同时低沉算力本钱,或成大模子竞争的焦点,因此对模子架构优化以及算力架构更新提出更高要求。

免责声明:如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作!更多信息从访问主页:qidao123.com:ToB企服之家,中国第一个企服评测及商务社交产业平台。

| 欢迎光临 ToB企服应用市场:ToB评测及商务社交产业平台 (https://dis.qidao123.com/) |

Powered by Discuz! X3.4 |