mvn clean package过程如图所示:

docker build -t grpc-server .

docker run -p 9090:9090 -v /data/logs:/app/logs grpc-server

docker-compose up后台启动全部容器:

docker-compose up -d通过使用编排文件,我们几乎不再需要手动维护各种 Docker 启动命令,而是可以通过同一的配置文件进行管理和部署。这种方式的最大优点在于,它显著简化了平凡 Docker 启动命令的维护和执行过程,避免了手动操纵带来的复杂性和堕落风险。

Linux:curl -L https://github.com/kubernetes/kompose/releases/download/v1.34.0/kompose-linux-amd64 -o kompose上面的命令执行完后,基本上我们就可以正常使用了。效果如图所示:

Linux ARM64:curl -L https://github.com/kubernetes/kompose/releases/download/v1.34.0/kompose-linux-arm64 -o kompose

chmod +x kompose

sudo mv ./kompose /usr/local/bin/kompose

kompose convert -f docker-compose.yaml

kubelet get storageclass因为我这是刚搭建的K8s环境,以是我这里表现的是没有,那么先搭建一个本地NFS服务器。

rpm -qa | grep nfs安装NFS 、RPC

rpm -qa | grep rpcbind

yum -y install nfs-utils rpcbind启动服务

systemctl start nfs rpcbind创建目录

mkdir -p /nfs-server/log/编辑export文件

chmod 666 /nfs-server/log/

vim /etc/exports

/nfs-server *(rw,sync,no_root_squash)

exportfs -r启动rpcbind、nfs服务

systemctl restart rpcbind自我测试一下是否可以联机

systemctl restart nfs

showmount -e localhost测试效果正常:

k apply -f st.yaml效果如下,启动成功:

kubectl get storageclass

kubectl apply -f pv.yaml启动成功,效果如图所示:

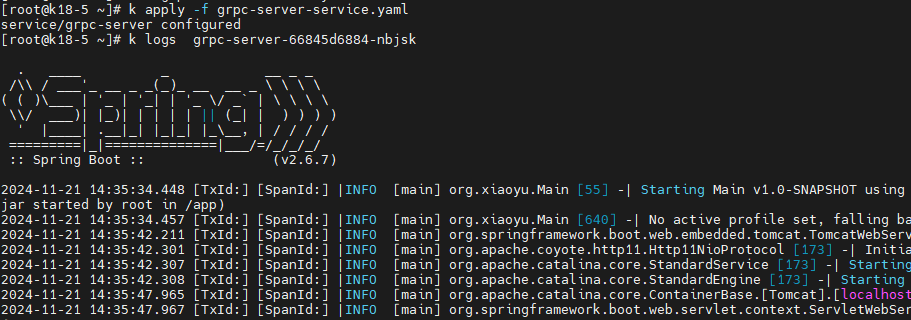

k apply -f grpc-server-xiaoyu-claim0-persistentvolumeclaim.yaml最后,正常启动service服务后可以看到正常分配了内网ip,但并不会被外网访问到。

k apply -f grpc-server-xiaoyu-deployment.yaml

k apply -f grpc-server-xiaoyu-service.yaml

kubectl scale deployment grpc-server-xiaoyu --replicas=2执行成功,效果如图所示:

| 欢迎光临 IT评测·应用市场-qidao123.com (https://dis.qidao123.com/) | Powered by Discuz! X3.4 |